一个模型不够用?那就加两个!多搞几个Agent(智能体)让它们自己开会讨论,效果肯定好。

这种“智能体越多越好”的直觉,似乎成了当下的行业共识。甚至有论文曾宣称“More agents is all you need”。但是,这种说法真的科学吗?

最近,来自Google Research、Google DeepMind和MIT的研究者们联合发表了一项重磅研究。结果显示:盲目增加智能体数量,在很多时候不仅没用,反而会让系统变笨、变慢、变贵。

这篇名为《迈向智能体系统扩展的科学》(Towards a Science of Scaling Agent Systems)的论文,通过180组严谨的受控实验,试图回答一个核心问题:我们到底什么时候该用多智能体?又该如何科学地设计它们的架构?

在接下来的内容中,本文将为您深入解读这篇论文的细节,揭开智能体协作背后的数学规律。

目前,大多数开发者在构建AI应用时,往往依赖经验法则(Heuristics)。比如,“我觉得这里应该加一个审核员Agent”,“我觉得那里需要一个搜索Agent”。但这种设计缺乏定量依据。

研究者指出,我们需要区分两类任务:

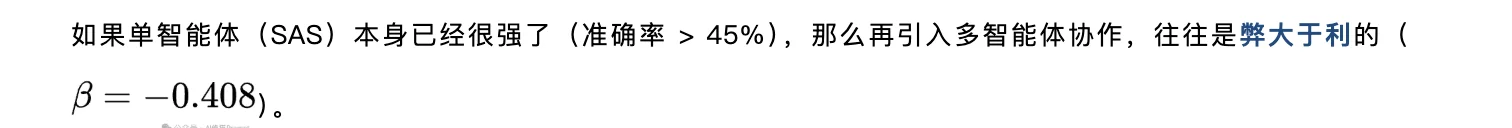

在静态任务上,多智能体确实能通过“投票”提升准确率。但在代理型任务中,情况完全不同。由于涉及多步交互,沟通成本(Coordination Overhead)和错误传播(Error Propagation)会成为致命杀手。

并且论文还提出了一个核心的理论权衡,值得您了解一下:上下文完整性(Context Integration)与多样性(Diversity)的博弈。

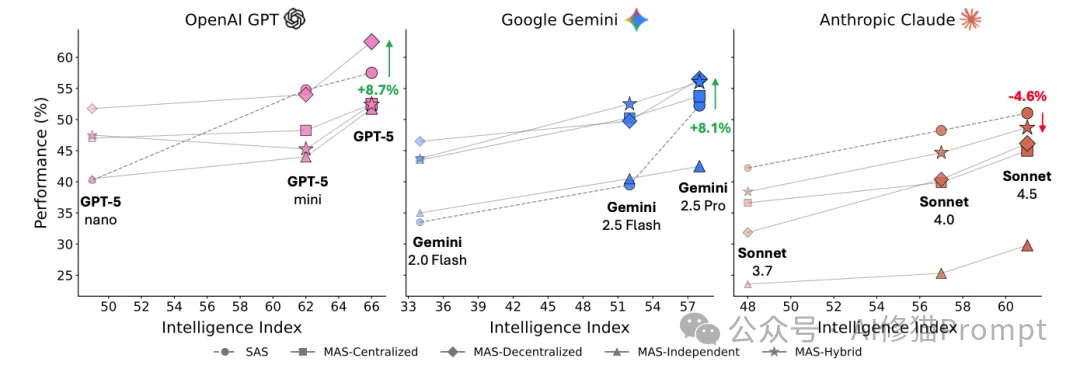

这张图把模型“聪明程度”(横轴)和完成一组 agent 任务的平均分(纵轴)放在一起,说明分数会随模型变强整体上升,但同样聪明的模型也会因为“怎么组织多个智能体”而拉开差距。

当引入多智能体时,系统必须面对信息碎片化(Information Fragmentation)的问题。

多智能体虽然带来了并行的多样性,但牺牲了记忆的完整性。这就是为什么在长链条推理任务中,多智能体容易“断片”的根本理论原因。

为了得出普适结论,研究者搭建了一个极其严谨的竞技场。

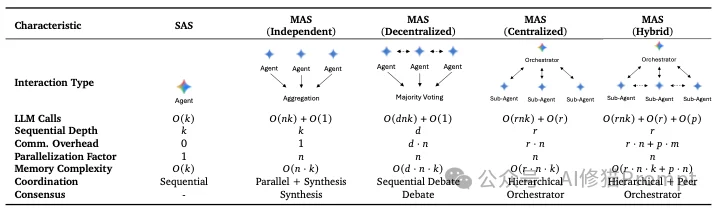

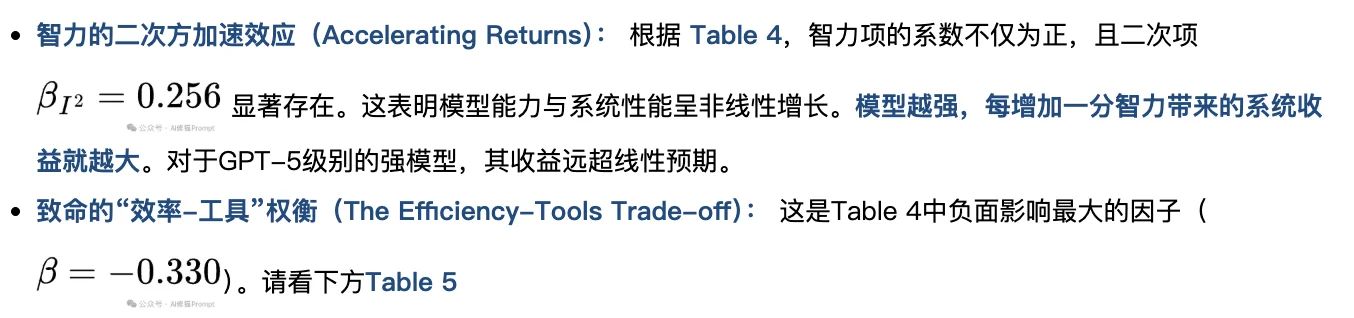

他们对比了五种最主流的智能体组织形式,统一使用LangChain框架,并配合LiteLLM进行模型调用。

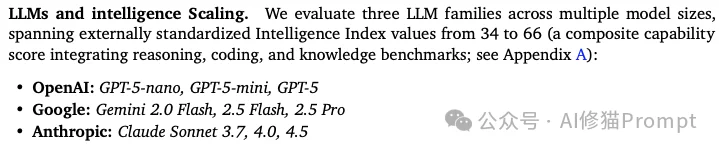

为了证明结论不局限于某一家公司,研究涵盖了 OpenAI (GPT-5系列)、Google (Gemini系列) 和 Anthropic (Claude系列),覆盖了从“轻量级”到“超强能力”的9个不同模型。

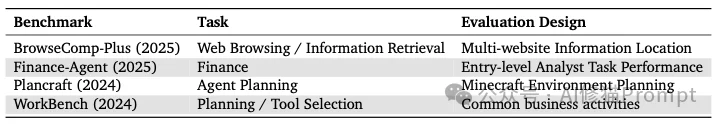

为了测试不同任务类型的影响,研究者选取了四个基准测试:

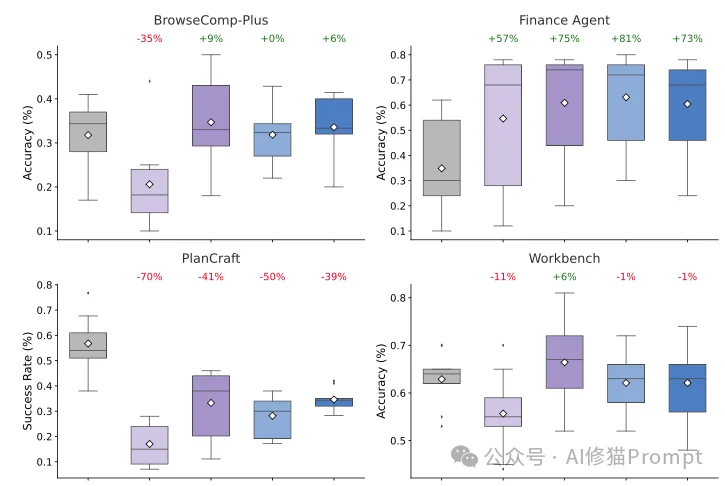

多智能体系统的表现极度依赖于任务结构,出现了从提升81%到暴跌70%的巨大反差。

1. 金融场景(Finance):多智能体完胜

2. 游戏规划(PlanCraft):多智能体惨败

这是一个非常反直觉的发现:当任务需要使用大量工具时,增加智能体反而会坏事。

您可能认为多智能体能“互相纠错”,但数据告诉我们,它们也可能“互相带偏”。

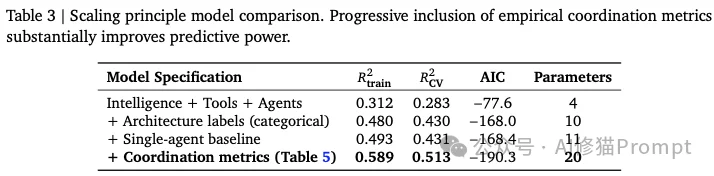

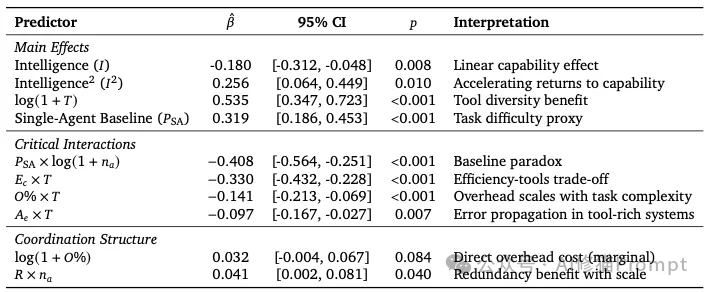

研究者没有止步于定性观察,而是推导出了一个普适的扩展预测模型(Scaling Principle)。

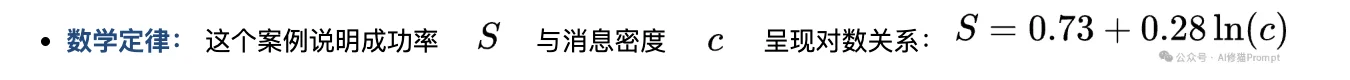

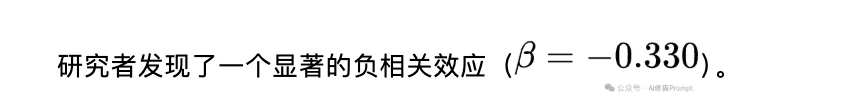

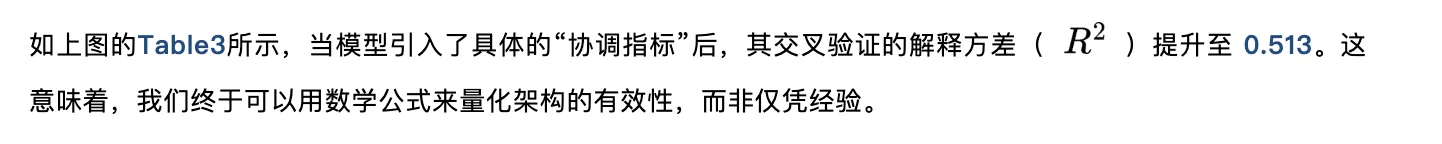

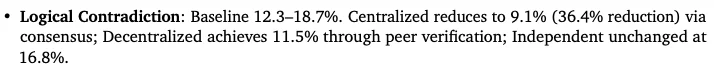

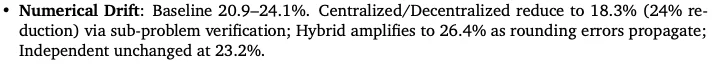

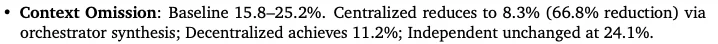

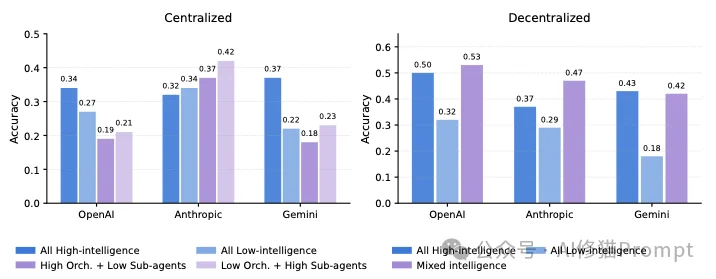

结合Table 4(回归系数表) 和Table 5(协调指标表),该模型揭示了决定系统生死的四大核心机制:

定义: 智能体对同一个实体给出了自相矛盾的断言(例如既说“X是真”又说“X是假”),或者得出的结论违背了它自己设定的前提。

定义: 这是多智能体系统(MAS)特有的错误类型。包括消息被误解、任务分配冲突、或智能体之间的状态同步错误。

在实验中,不同厂商的模型展现出了截然不同的协作风格,这对于您选择基础模型非常有参考价值。

有趣的“异构”发现: 研究者尝试了“混搭”用一个弱模型做经理,指挥强模型干活。

谷歌的这篇论文说明多智能体不是万能药。 真正的“扩展(Scaling)”不是简单地堆砌Agent的数量,而是根据任务的属性(结构、复杂度、依赖关系)来匹配最合适的架构。

正如论文总结的那样,只有当任务可分解、单人能力不足、且工具干扰可控时,多智能体协作的光芒才会真正显现。对于其它情况,也许我们要回归本质:一个足够聪明的单体,往往胜过一群嘈杂的乌合之众。

文章来自于微信公众号 “AI修猫Prompt”,作者 “AI修猫Prompt”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0