Meta公开抄阿里Qwen作业,还闭源了...

Meta公开抄阿里Qwen作业,还闭源了...Meta的开源时代,要结束了。彭博社爆料,明年春季,Meta将发布一款代号为「Avocado(牛油果)」的模型。而这款新模型,很可能是「闭源」的。但如果仅仅是闭源,还不至于如此引人注目。真正让市场炸裂的是另一条更劲爆的消息:这款闭源模型,竟然在训练过程中使用了阿里巴巴的AI。

Meta的开源时代,要结束了。彭博社爆料,明年春季,Meta将发布一款代号为「Avocado(牛油果)」的模型。而这款新模型,很可能是「闭源」的。但如果仅仅是闭源,还不至于如此引人注目。真正让市场炸裂的是另一条更劲爆的消息:这款闭源模型,竟然在训练过程中使用了阿里巴巴的AI。

灵初智能发布全球首个具身原生人类数据采集方案 Psi-SynEngine。该方案由灵初智能全栈自研,包含便携式外骨骼触觉手套数采套装、大规模 in the wild 数采数据管线、基于世界模型和强化学习的跨本体数据迁移模型,并已率先将采集到的人类数据应用于物流等真实场景。

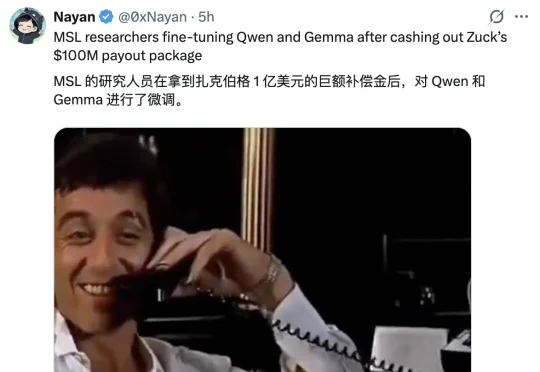

如果说大模型的预训练(Pre-training)是一场拼算力、拼数据的「军备竞赛」,那么测试时扩展(Test-time scaling, TTS)更像是一场在推理阶段进行的「即时战略游戏」。

Anthropic联合创始人兼首席科学官Jared Kaplan,认为在2027-2030年期间,我们将不得不做出是否允许 AI 自我进化的抉择,而允许的话很可能导致AI失控,毁灭全人类。Anthropic在迅速提升AI模型性能不断逼近AGI奇点的同时,也在同时让「9人特种部队」用1.4万字的「AI宪法」防范AI失控。

今年 10 月,专注构建世界模型的 General Intuition 完成了高达 1.34 亿美元的种子轮融资。这笔融资由硅谷传奇投资人 Vinod Khosla 领投,这是他自 2019 年首次投资 OpenAI 以来开出的最大单笔种子轮投资,也标志着他在 LLM 之后对下一代智能范式做出的一次重大下注。

基于扩散的大语言模型 (dLLM) 凭借全局解码和双向注意力机制解锁了原生的并行解码和受控生成的潜力,最近吸引了广泛的关注。例如 Fast-dLLM 的现有推理框架通过分块半自回归解码进一步实现了 dLLM 对 KV cache 的支持,挑战了传统自回归 LLMs 的统治地位。

他是SIGGRAPH 50年历史上第一位、也是迄今唯一一位登上大会主题演讲舞台的中国人,与英伟达黄仁勋等行业领袖同台。

有关大语言模型的理论基础,可能要出现一些改变了。

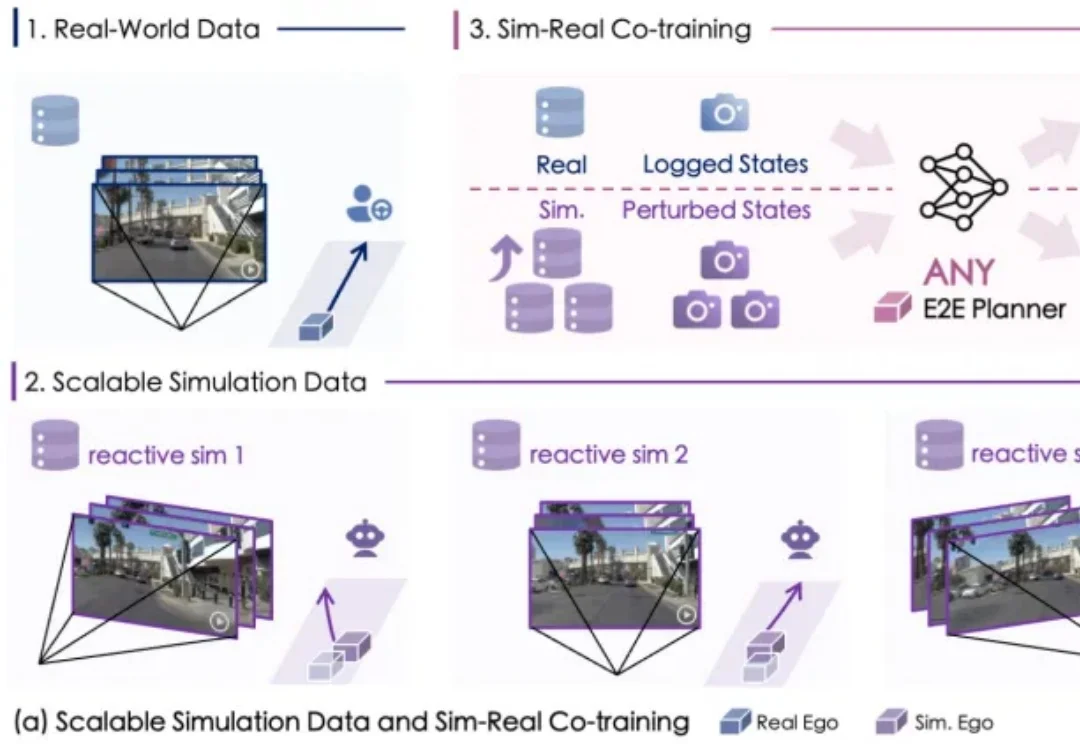

自动驾驶数据荒怎么破?

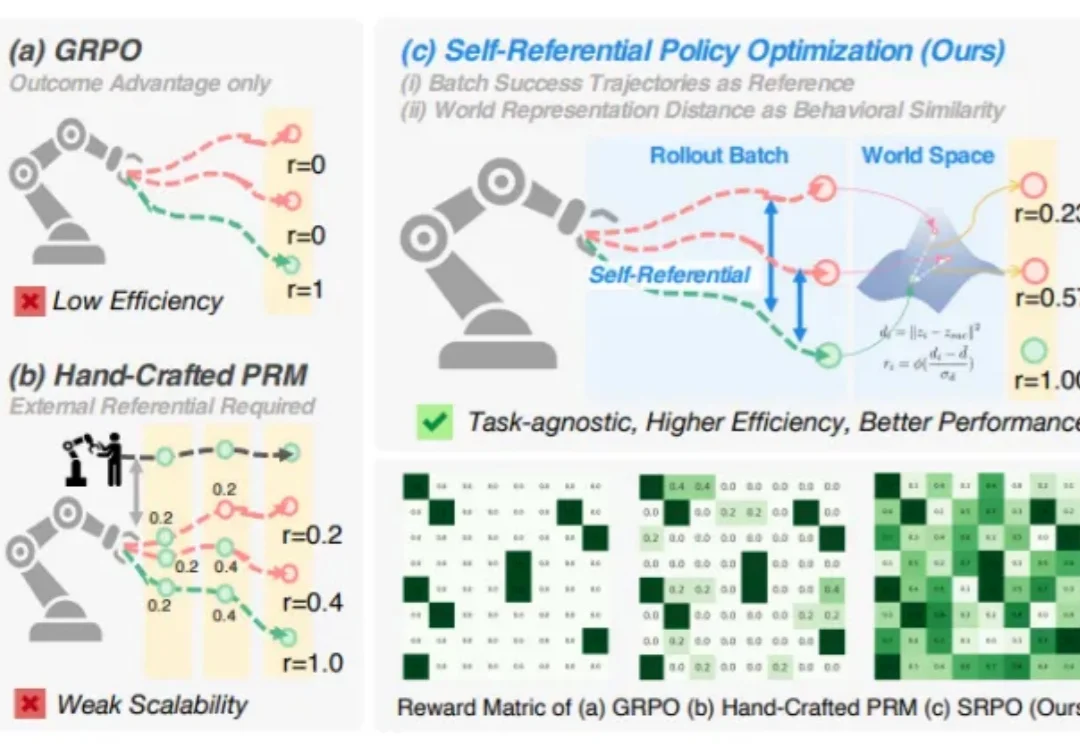

你是否想过,机器人也能像人一样,从失败中学习,不断自我提升?