八年后,Meta教会了Transformer「显式思考」

八年后,Meta教会了Transformer「显式思考」最近的 Meta 可谓大动作不断,一边疯狂裁人,一边又高强度产出论文。

最近的 Meta 可谓大动作不断,一边疯狂裁人,一边又高强度产出论文。

Transformer之父「叛逃」?8年前掀起AI革命的男人,如今嫌「自己孩子」太吵太卷!当资本狂飙、论文堆积如山,他却高喊:是时候放弃Transformer,重新找回好奇心了。

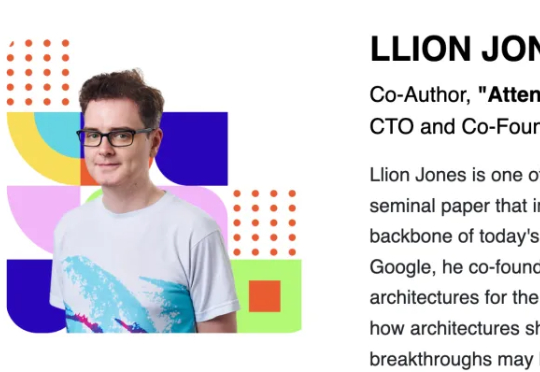

都说苹果AI慢半拍,没想到新研究直接在Transformer头上动土。(doge) 「Mamba+工具」,在Agent场景更能打!

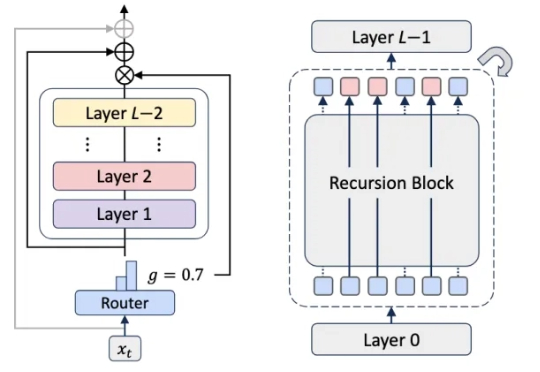

在近日的一次访谈中,Andrej Karpathy深入探讨了AGI、智能体与AI未来十年的走向。他认为当前的「智能体」仍处早期阶段,强化学习虽不完美,却是目前的最优解。他预测未来10年的AI架构仍然可能是类似Transformer的巨大神经网络。

噫吁嚱! 那个昔日叱咤风云的开源框架——TensorFlow,已然是行将就木了。

太夸张!百度办AI“培训班”,大佬都纷纷要来拜师学艺。 刚刚百度举办了首席AI架构师培养计划 (AICA)的第九期开学典礼,一看吓一跳,本期学员里可谓是卧虎藏龙。

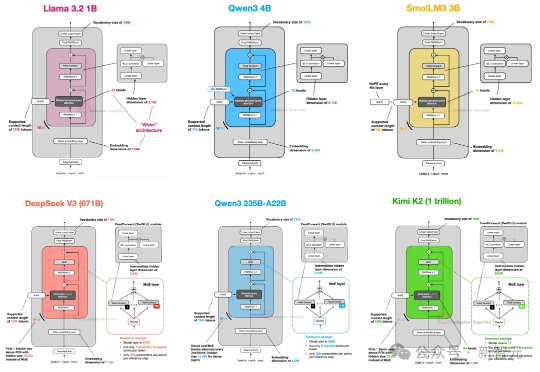

从GPT-2到DeepSeek-V3和Kimi K2,架构看似未变,却藏着哪些微妙升级?本文深入剖析2025年顶级开源模型的创新技术,揭示滑动窗口注意力、MoE和NoPE如何重塑效率与性能。

大型语言模型已展现出卓越的能力,但其部署仍面临巨大的计算与内存开销所带来的挑战。随着模型参数规模扩大至数千亿级别,训练和推理的成本变得高昂,阻碍了其在许多实际应用中的推广与落地。

未来AI路线图曝光!谷歌发明了Transformer,但在路线图中承认:现有注意力机制无法实现「无限上下文」,这意味着下一代AI架构,必须「从头重写」。Transformer的时代,真的要终结了吗?在未来,谷歌到底有何打算?

RNN太老,Transformer太慢?谷歌掀翻Transformer王座,用「注意力偏向+保留门」取代传统遗忘机制,重新定义了AI架构设计。全新模型Moneta、Yaad、Memora,在多个任务上全面超越Transformer。这一次,谷歌不是调参,而是换脑!