商汤披露:50篇论文入选CVPR 2024

商汤披露:50篇论文入选CVPR 2024CVPR正在进行中,中国科研力量再次成为场内外焦点之一。

CVPR正在进行中,中国科研力量再次成为场内外焦点之一。

基于 Transformer架构的大型语言模型在各种基准测试中展现出优异性能,但数百亿、千亿乃至万亿量级的参数规模会带来高昂的服务成本。例如GPT-3有1750亿参数,采用FP16存储,模型大小约为350GB,而即使是英伟达最新的B200 GPU 内存也只有192GB ,更不用说其他GPU和边缘设备。

本⽂介绍由清华等⾼校联合推出的⾸个开源的⼤模型⽔印⼯具包 MarkLLM。MarkLLM 提供了统⼀的⼤模型⽔印算法实现框架、直观的⽔印算法机制可视化⽅案以及系统性的评估模块,旨在⽀持研究⼈员⽅便地实验、理解和评估最新的⽔印技术进展。通过 MarkLLM,作者期望在给研究者提供便利的同时加深公众对⼤模型⽔印技术的认知,推动该领域的共识形成,进⽽促进相关研究的发展和推⼴应⽤。

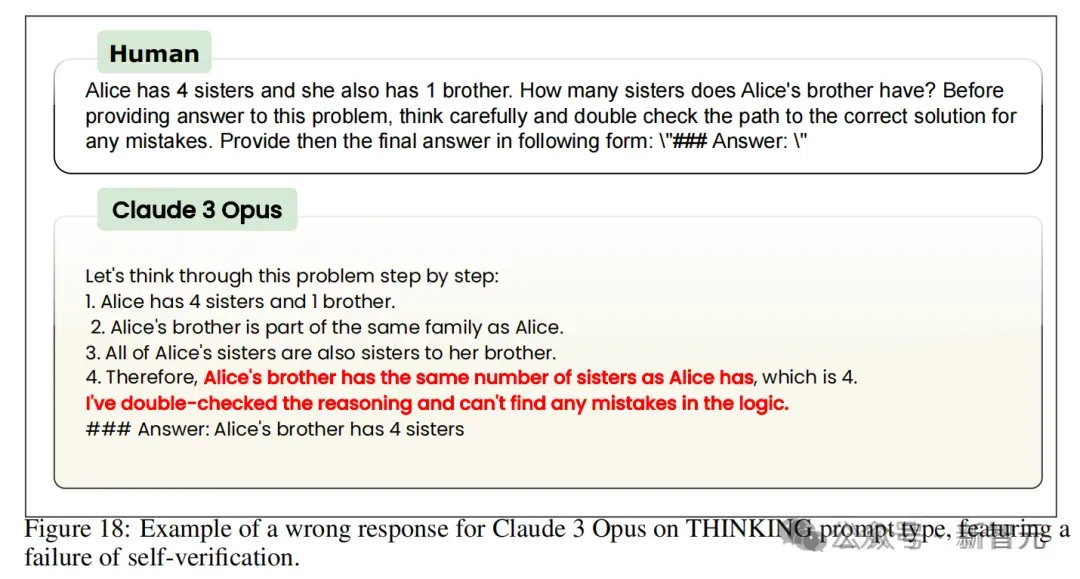

大语言模型提示中,竟有不少「怪癖」:重复某些内容,准确性就大大提高;人名变匿名,准确性就大大下降。最近,马里兰OpenAI等机构的30多位研究者,首次对LLM的提示技术进行了大规模系统研究,并发布75页详尽报告。

DeepMind最近发表的一篇论文提出用混合架构的方法解决Transformer模型的推理缺陷。将Transformer的NLU技能与基于GNN的神经算法推理器(NAR)的强大算法推理能力相结合,可以实现更加泛化、稳健、准确的LLM推理。

大语言模型(LLM)的迅速发展,引发了关于如何评估其公平性和可靠性的热议。

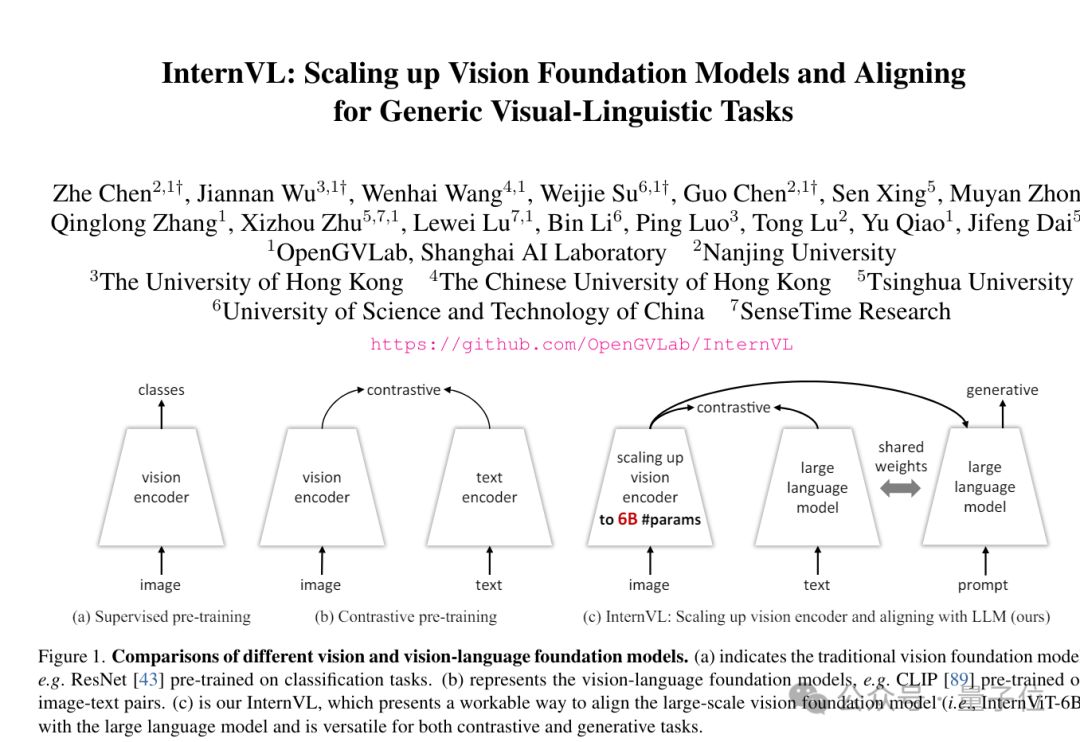

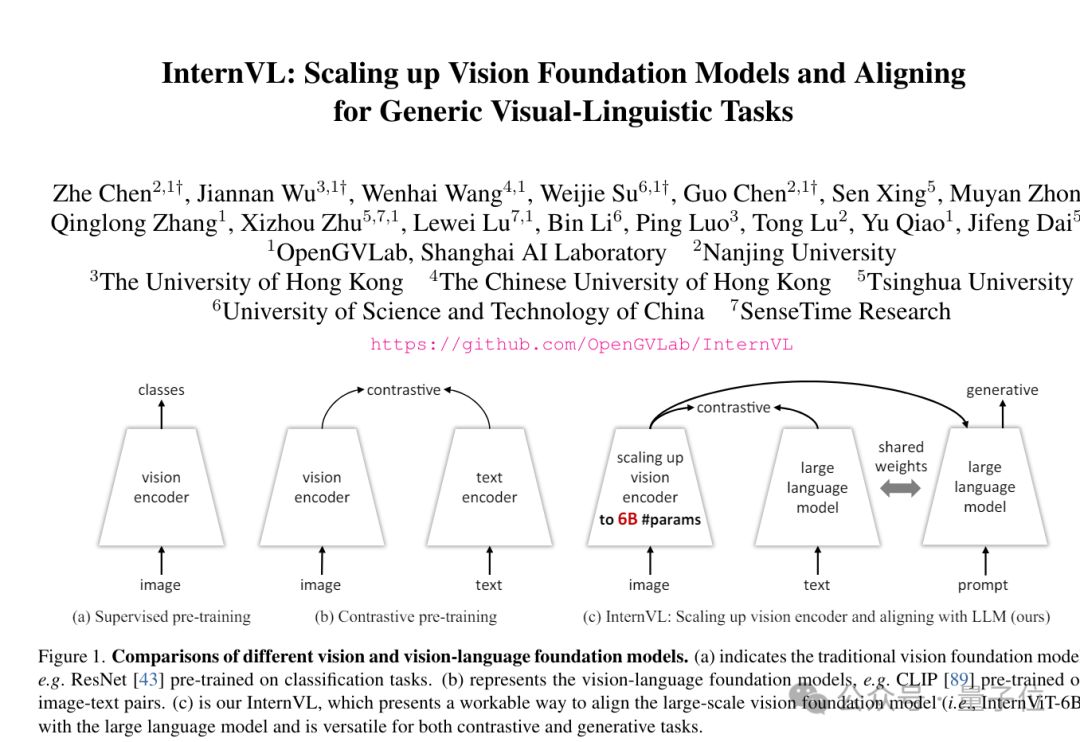

当前主流的视觉语言模型(VLM)主要基于大语言模型(LLM)进一步微调。因此需要通过各种方式将图像映射到 LLM 的嵌入空间,然后使用自回归方式根据图像 token 预测答案。

大模型是世界模型吗?UA微软等机构最新研究发现,GPT-4在复杂环境的模拟中,准确率甚至不及60%。对此,LeCun激动地表示,世界模型永远都不可能是LLM。

训练数据的数量和质量,对LLM性能的重要性已经是不言自明的事实。然而,Epoch AI近期的一篇论文却给正在疯狂扩展的AI模型们泼了冷水,他们预测,互联网上可用的人类文本数据将在四年后,即2028年耗尽。

才用了112台A800,就能训出性能达GPT-4 90%的万亿参数大模型?智源的全球首个低碳单体稠密万亿参数大模型Tele-FLM,有望解决全球算力紧缺难题!此外,全新思路的原生多模态「世界模型」Emu 3等都浅亮相了一把。2024的智源大会,依然是星光熠熠,学术巨佬含量超标。