“金凤花”智能体与定制认知架构的威力

“金凤花”智能体与定制认知架构的威力很多人认为智能体(agent)是生成式人工智能的未来趋势。但对于智能体应该如何发展大家却看法不一。基于简单的链式流程的智能体还不够灵活或强大,没有真正利用好 LLM 范式,而完全自主的智能体往往又会失效,没法用。在二者之间找到平衡的“金凤花”智能体正赢得青睐。

很多人认为智能体(agent)是生成式人工智能的未来趋势。但对于智能体应该如何发展大家却看法不一。基于简单的链式流程的智能体还不够灵活或强大,没有真正利用好 LLM 范式,而完全自主的智能体往往又会失效,没法用。在二者之间找到平衡的“金凤花”智能体正赢得青睐。

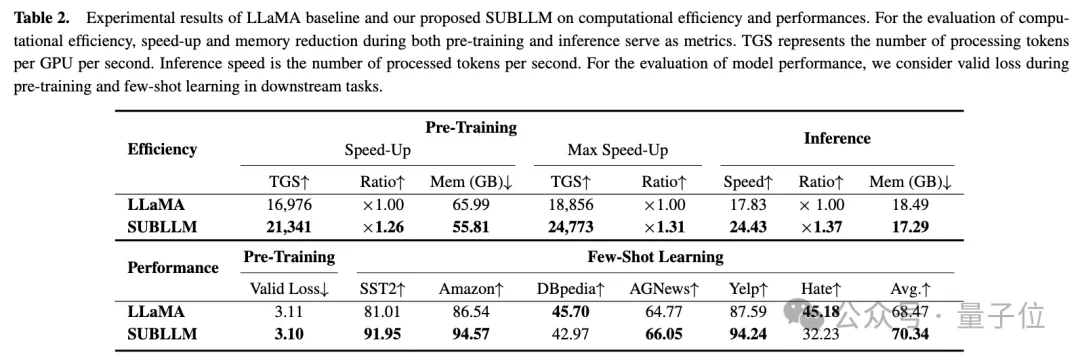

大模型推理速度提升50%以上,还能保证少样本学习性能!

618卷进大模型,谁是真正的赢家

在原有的应用和产业格局上思考AI,那不管ToB还是ToC可能就都是错的。思考优化百货运营是想不出电商的。

在人工智能领域的发展过程中,对大语言模型(LLM)的控制与指导始终是核心挑战之一,旨在确保这些模型既强大又安全地服务于人类社会。早期的努力集中于通过人类反馈的强化学习方法(RLHF)来管理这些模型,成效显著,标志着向更加人性化 AI 迈出的关键一步。

自 ChatGPT 发布以来,大型语言模型(LLM)已经成为推动人工智能发展的关键技术。

让我们训练一个 Storyteller。

在GPT-4发布后14.5个月里,LLM领域似乎已经没什么进步了?近日,马库斯的一句话引发了全网论战。大模型烧钱却不赚钱,搞AI的公司表示:难办!

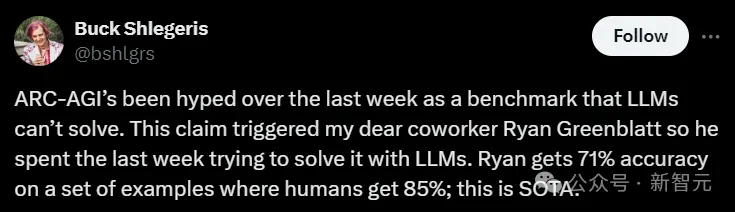

号称不可能轻易被击败的AGI基准ARC-AGI被GPT-4o撼动,GPT-4o以在公共测试集50%、在训练集71%的准确率成为了新的SOTA!

「AI教父」Geoffrey Hinton在最近的采访中表达了自己对AI智能的理解——LLM并不是简单的统计模型,已经具备了理解能力。与此同时,网友翻出了去年12月的「过期」视频,惊奇地发现Hinton早就「叛变」了,竟然对超级AI取代人类的未来表示支持。