国产最强语音大模型诞生,MaskGCT宣布开源,声音效果媲美人类

国产最强语音大模型诞生,MaskGCT宣布开源,声音效果媲美人类近期,港中大(深圳)联手趣丸科技联合推出了新一代大规模声音克隆 TTS 模型 ——MaskGCT。该模型在包含 10 万小时多语言数据的 Emilia 数据集上进行训练,展现出超自然的语音克隆、风格迁移以及跨语言生成能力,同时保持了较强的稳定性。MaskGCT 已在香港中文大学(深圳)与上海人工智能实验室联合开发的开源系统 Amphion 发布。

近期,港中大(深圳)联手趣丸科技联合推出了新一代大规模声音克隆 TTS 模型 ——MaskGCT。该模型在包含 10 万小时多语言数据的 Emilia 数据集上进行训练,展现出超自然的语音克隆、风格迁移以及跨语言生成能力,同时保持了较强的稳定性。MaskGCT 已在香港中文大学(深圳)与上海人工智能实验室联合开发的开源系统 Amphion 发布。

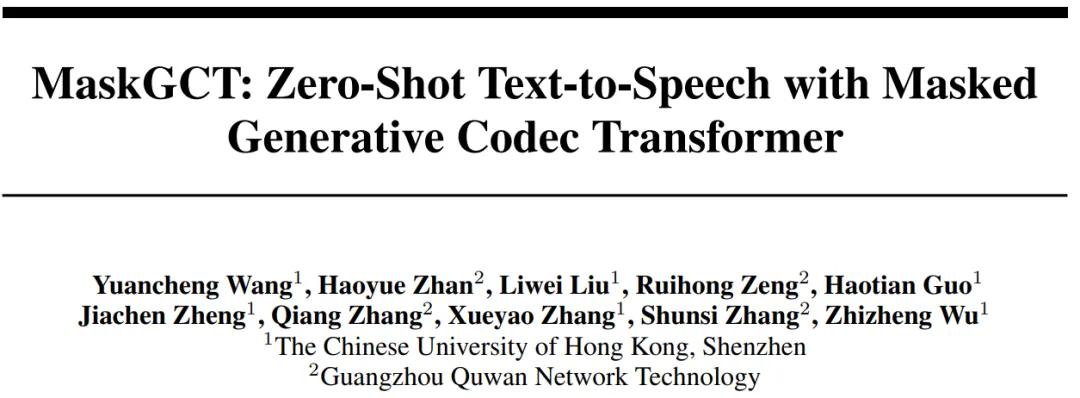

10 月 4 日,播客节目 BG2(Brad Gerstner 和 Clark Tang)邀请到了英伟达 CEO 黄仁勋,他们一起讨论了 AGI、机器学习加速、英伟达的竞争优势、推理与训练的重要性、AI 领域未来的市场动态、AI 对各个行业的影响、工作的未来、AI 提高生产力的潜力、开源与闭源之间的平衡、马斯克的 Memphis 超级集群、X.ai、OpenAI、AI 的安全开发等。

苹果研究者发现:无论是OpenAI GPT-4o和o1,还是Llama、Phi、Gemma和Mistral等开源模型,都未被发现任何形式推理的证据,而更像是复杂的模式匹配器。无独有偶,一项多位数乘法的研究也被抛出来,越来越多的证据证实:LLM不会推理!

家人们,一觉醒来,又吃了一则新瓜:

微软 10 年「老兵」选择离开。

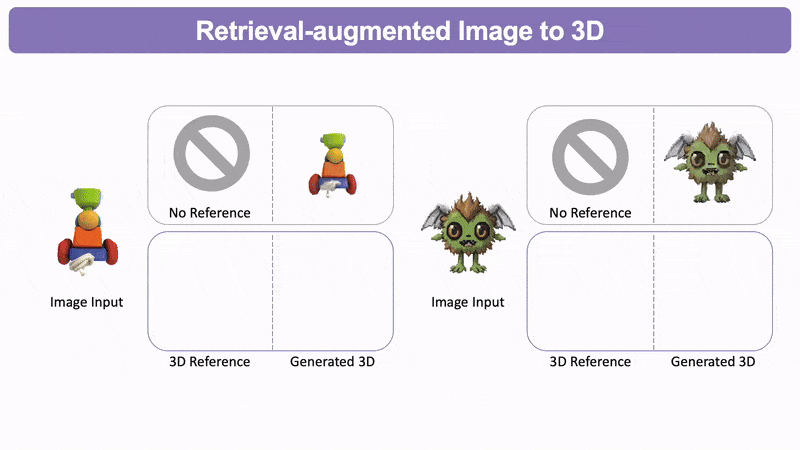

3D生成也能支持检索增强(RAG)了。

智东西8月28日消息,据TechCrunch报道,美国西雅图创企Supio在周二宣布完成了2500万美元超额认购A轮融资。本轮投资由Sapphire Ventures领投,Bonfire Ventures和Foothill Ventures参与投资。截至目前,Supio已经筹集到了3300万美元,计划在短期内扩大客户基础、平台规模并最终将业务扩展到其他法律领域。

今天,生成式AI已成为技术和金融市场中的重要话题。无论是通过风险投资、股票上涨、媒体报道,还是财报电话会议中的提及次数来衡量,AI的崛起都是显而易见的。

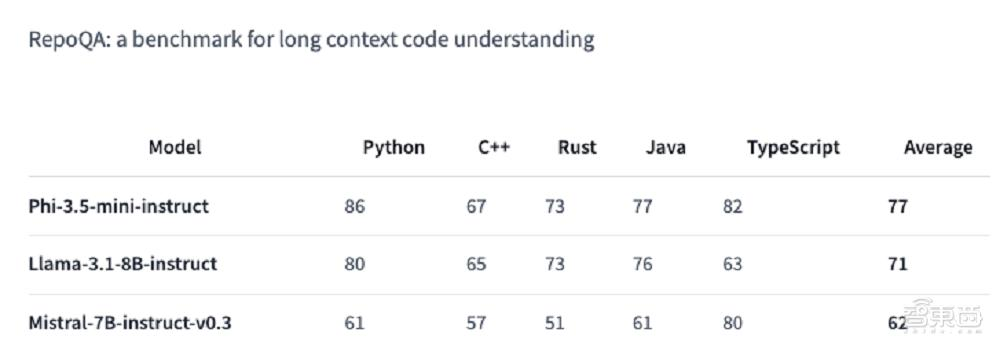

轻量级模型的春天要来了吗?

微软Phi 3.5系列上新了!mini模型小而更美,MoE模型首次亮相,vision模型专注多模态。