超越GPT-5、Gemini Deep Research!人大高瓴AI金融分析师,查数据、画图表、写研报样样精通

超越GPT-5、Gemini Deep Research!人大高瓴AI金融分析师,查数据、画图表、写研报样样精通能自动查数据、写分析、画专业金融图表的AI金融分析师来了!最近,中国人民大学高瓴人工智能学院提出了一个面向真实金融投研场景的多模态研报生成系统——玉兰·融观(Yulan-FinSight)。

能自动查数据、写分析、画专业金融图表的AI金融分析师来了!最近,中国人民大学高瓴人工智能学院提出了一个面向真实金融投研场景的多模态研报生成系统——玉兰·融观(Yulan-FinSight)。

最近,清华大学教授、智谱AI首席科学家唐杰发了一条长微博,总结了自己2025年对大模型进展的感悟。从预训练到中后训练、长尾场景的对齐能力,再到Agent、多模态和具身智能的发展,其中有不少亮点。

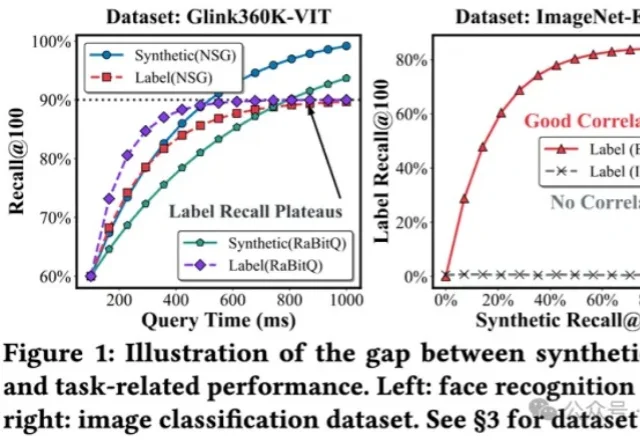

将多模态数据纳入到RAG,甚至Agent框架,是目前LLM应用领域最火热的主题之一,针对多模态数据最自然的召回方式,便是向量检索。

「高烧」三年后,AI行业终于冷静:Scaling红利即将耗尽,单纯堆参数绝非良药。但商汤已胸有成竹。

多模态大语言模型(MLLMs)已成为AI视觉理解的核心引擎,但其在真实世界视觉退化(模糊、噪声、遮挡等)下的性能崩溃,始终是制约产业落地的致命瓶颈。

今天,在 FORCE 原动力大会上,火山引擎发布豆包大模型1.8、豆包视频生成模型 Seedance 1.5 pro。经过一年多的持续升级,豆包大模型家族在多模态理解和生成能力、Agent 能力上,已位于全球第一梯队。

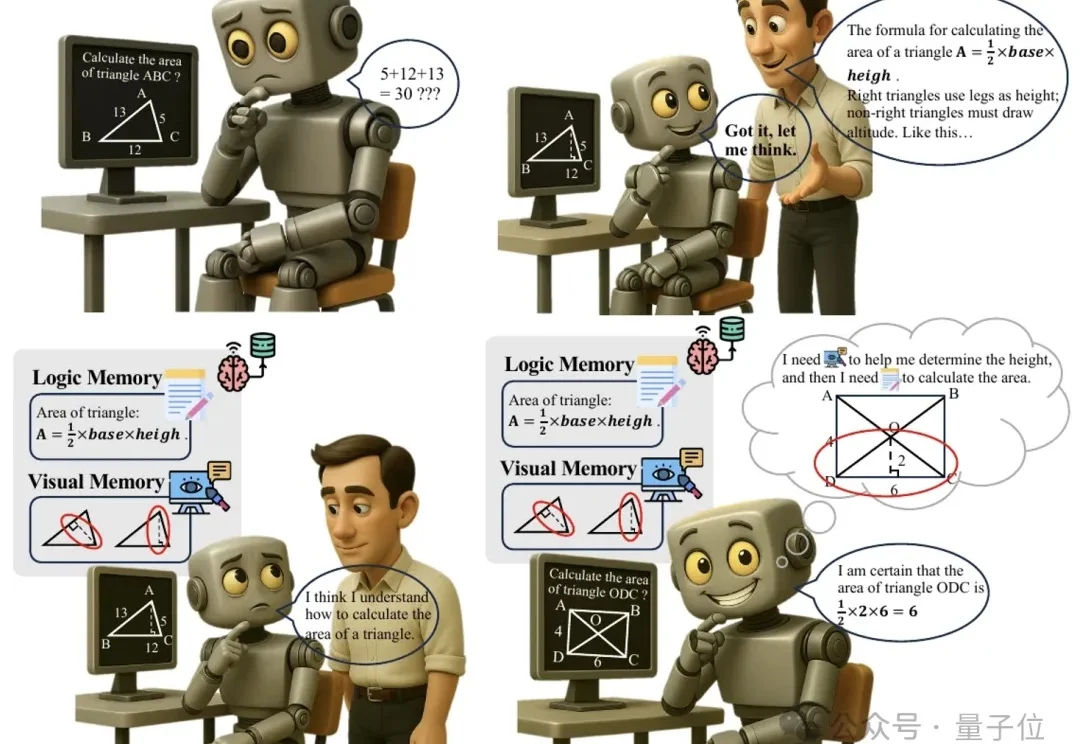

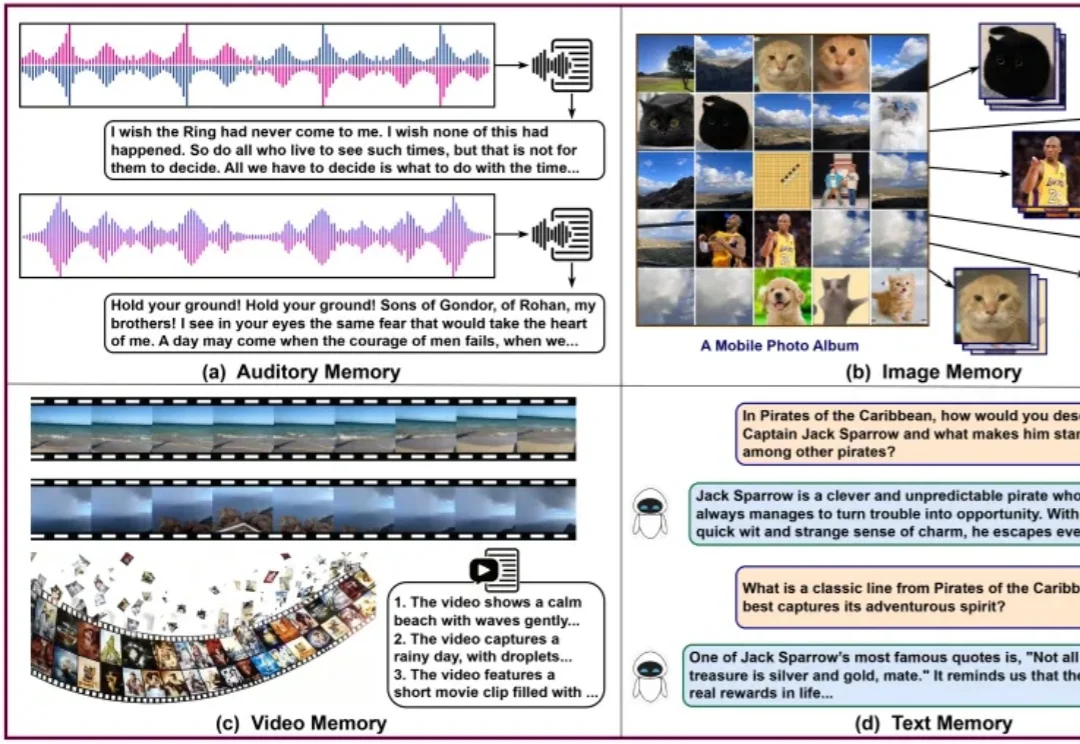

多模态推理又有新招,大模型“记不住教训”的毛病有治了。

一页纯文本的记忆是看不清世界的。

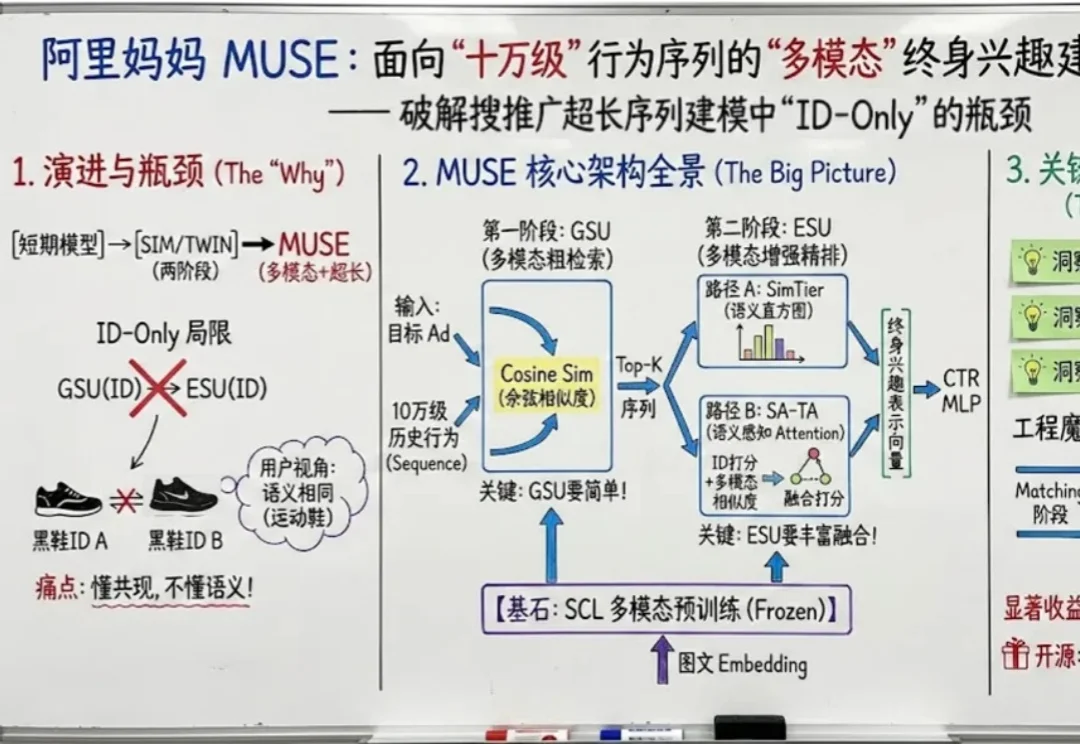

如果把用户在互联网上留下的每一个足迹都看作一段记忆,那么现在的推荐系统大多患有 “短期健忘症”。

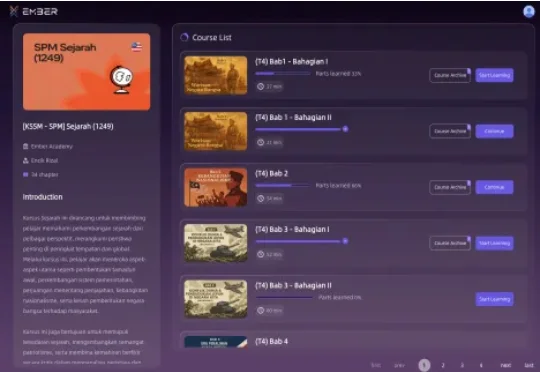

全球首个多模态交互式知识智能体服务商「玄华智能 Ember AI」已完成数千万元人民币天使轮融资,本轮由云时资本独家投资,逐浪资本担任长期独家财务顾问。「玄华智能」由一支兼具深厚互联网产品背景、顶尖AI技术实力和大规模商业化运营经验的团队创立。