文档处理效能飙升!浩鲸科技“文档大模型”核心技术揭秘!

文档处理效能飙升!浩鲸科技“文档大模型”核心技术揭秘!在当今大模型技术日新月异的背景下,数据已跃升为构建企业大模型知识库、优化训练与微调,乃至驱动模型创新不可或缺的核心要素。

来自主题: AI资讯

7979 点击 2024-09-25 20:18

在当今大模型技术日新月异的背景下,数据已跃升为构建企业大模型知识库、优化训练与微调,乃至驱动模型创新不可或缺的核心要素。

近期,浙大和 Salesforce 学者进一步发现:语言模型或许帮助有限,但是图像模型能够有效地迁移到时序预测领域。

比LoRA更高效的模型微调方法来了——

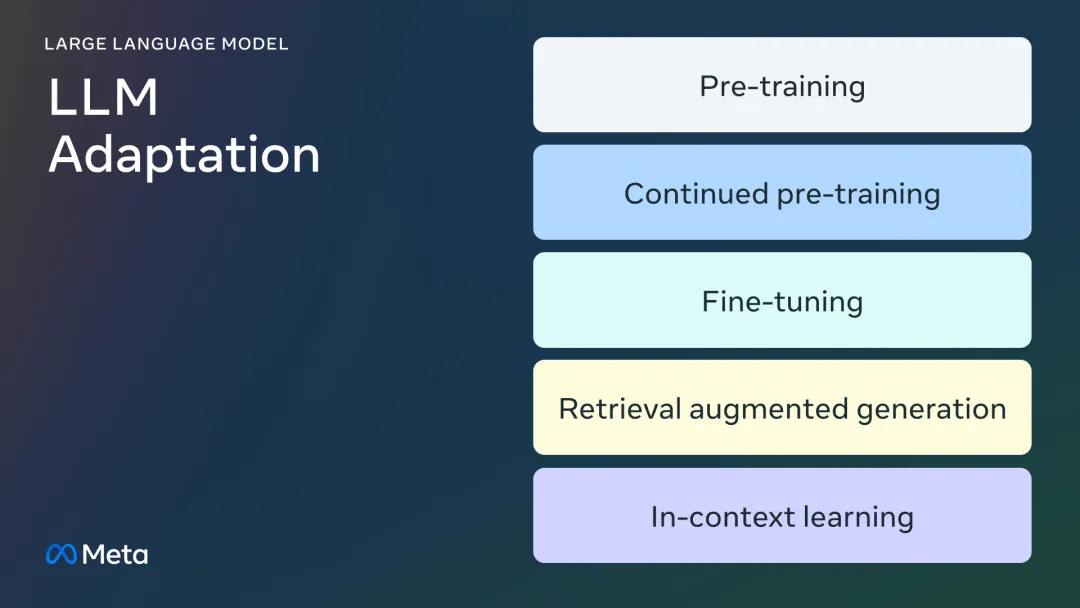

微调的所有门道,都在这里了。

OpenAI推出GPT-4o模型微调功能。

一觉醒来,OpenAI又上新功能了:

合成数据2.0秘诀曝光了!来自微软的研究人员们提出了智能体框架AgentInstruct,能够自动创建大量、多样化的合成数据。经过合成数据微调后的模型Orca-3,在多项基准上刷新了SOTA。

席卷开源界的AI生图王者诞生了!发布半个月,Flux已经成为替代Midjourney的宠儿。各路开发者们开始用自己的照片微调LoRA,一人拿捏多种风格。

互相检查,让小模型也能解决大问题。

发布40天后,最强开源模型Llama 3.1 405B等来了微调版本的发布。但不是来自Meta,而是一个专注于开放模型的神秘初创Nous Research。