清华微软最新力作:用物理学革新Transformer注意力,「大海捞针」精度暴涨30%!

清华微软最新力作:用物理学革新Transformer注意力,「大海捞针」精度暴涨30%!随着诺贝尔物理学奖颁给了「机器学习之父」Geoffrey Hinton,另一个借鉴物理学概念的模型架构也横空出世——微软清华团队的最新架构Differential Transformer,从注意力模块入手,实现了Transformer的核心能力提升。

随着诺贝尔物理学奖颁给了「机器学习之父」Geoffrey Hinton,另一个借鉴物理学概念的模型架构也横空出世——微软清华团队的最新架构Differential Transformer,从注意力模块入手,实现了Transformer的核心能力提升。

Transformer 的强大实力已经在诸多大型语言模型(LLM)上得到了证明,但该架构远非完美,也有很多研究者致力于改进这一架构,比如机器之心曾报道过的 Reformer 和 Infini-Transformer。

生成式AI(GenAI),尤其是以OpenAI的ChatGPT为代表,人们发现,这些大模型在一年多后的性能表现远不及刚发布时那样令人惊艳了。

Transformer计算,竟然直接优化到乘法运算了。MIT两位华人学者近期发表的一篇论文提出:Addition is All You Need,让LLM的能耗最高降低95%。

这样一套组合拳打下去,AI厂商大概率就会乖乖向网站付费了。

通用机器人模型,目前最大的障碍便是「异构性」。

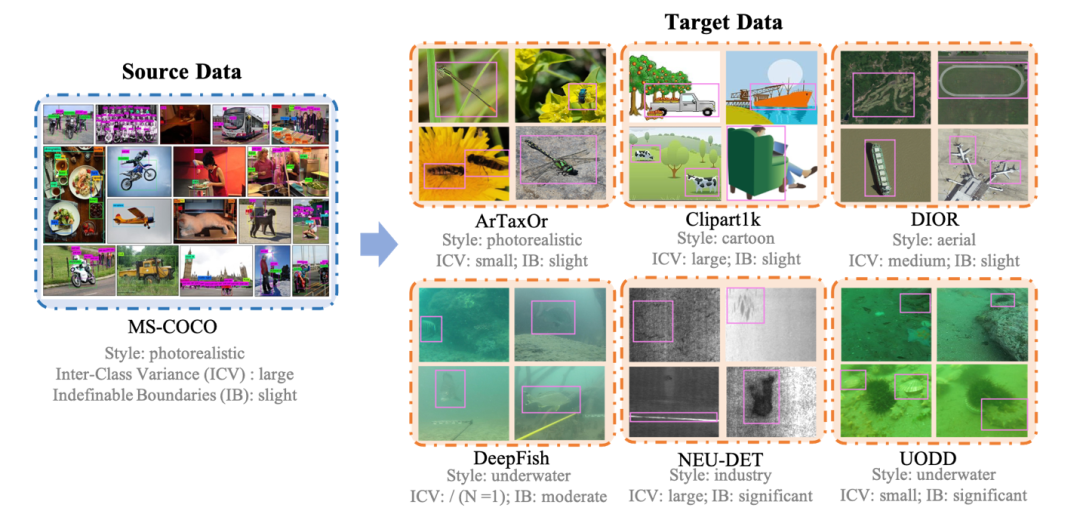

解决跨域小样本物体检测问题,入选ECCV 2024。

挑战Transformer,MIT初创团队推出LFM(Liquid Foundation Model)新架构模型爆火。

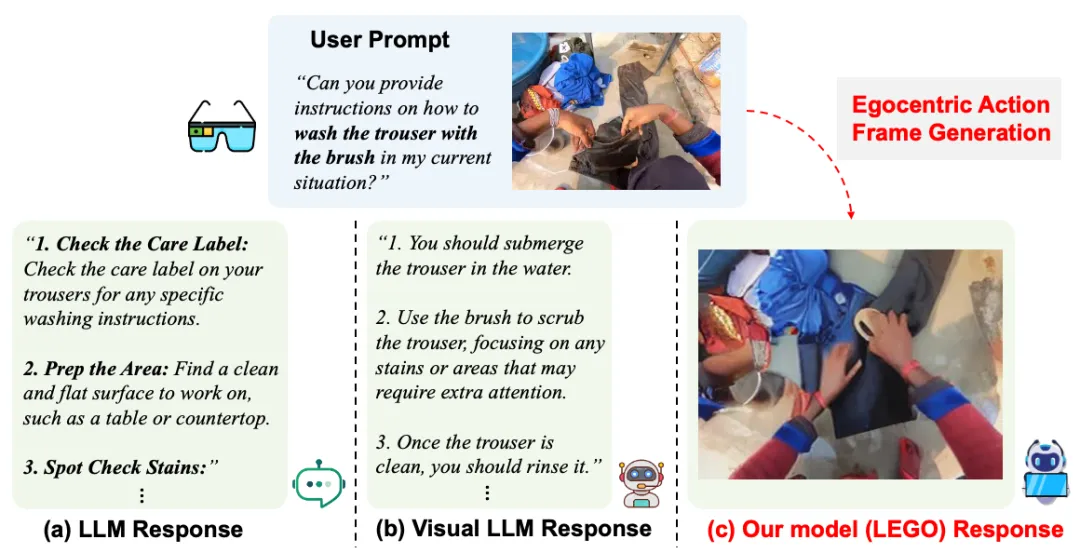

如何基于用户的问题和当前场景的照片,生成同一场景下的第一视角的动作图像,从而更准确地指导用户执行下一步行动?

EMOVA(EMotionally Omni-present Voice Assistant),一个能够同时处理图像、文本和语音模态,能看、能听、会说的多模态全能助手,并通过情感控制,拥有更加人性化的交流能力。