谷歌430万颗TPU暴击CUDA护城河!Meta「割肉」助攻

谷歌430万颗TPU暴击CUDA护城河!Meta「割肉」助攻Meta腾出CoWoS排产「让路」,加上台积电的积极扩产,2026年谷歌把TPU的「算力水龙头」拧到最大,预期产能飙升至430万颗,猛攻英伟达CUDA护城河。

Meta腾出CoWoS排产「让路」,加上台积电的积极扩产,2026年谷歌把TPU的「算力水龙头」拧到最大,预期产能飙升至430万颗,猛攻英伟达CUDA护城河。

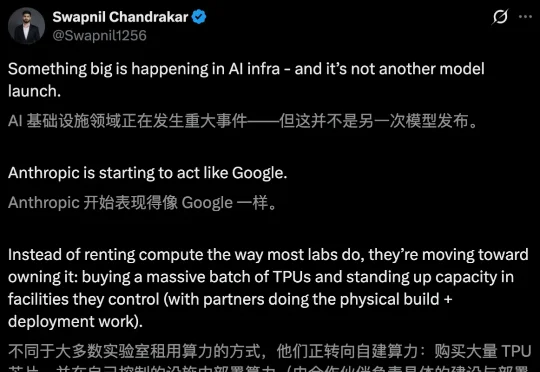

2026年开局,Anthropic未发一弹已占先机!谷歌首席工程师Jaana Dogan连发多帖,高度赞扬Claude Opus 4.5——没有图像/音频模型、巨大的上下文,仅有一款专注编码的Claude,Anthropic依旧是OpenAI谷歌最有力竞争者。

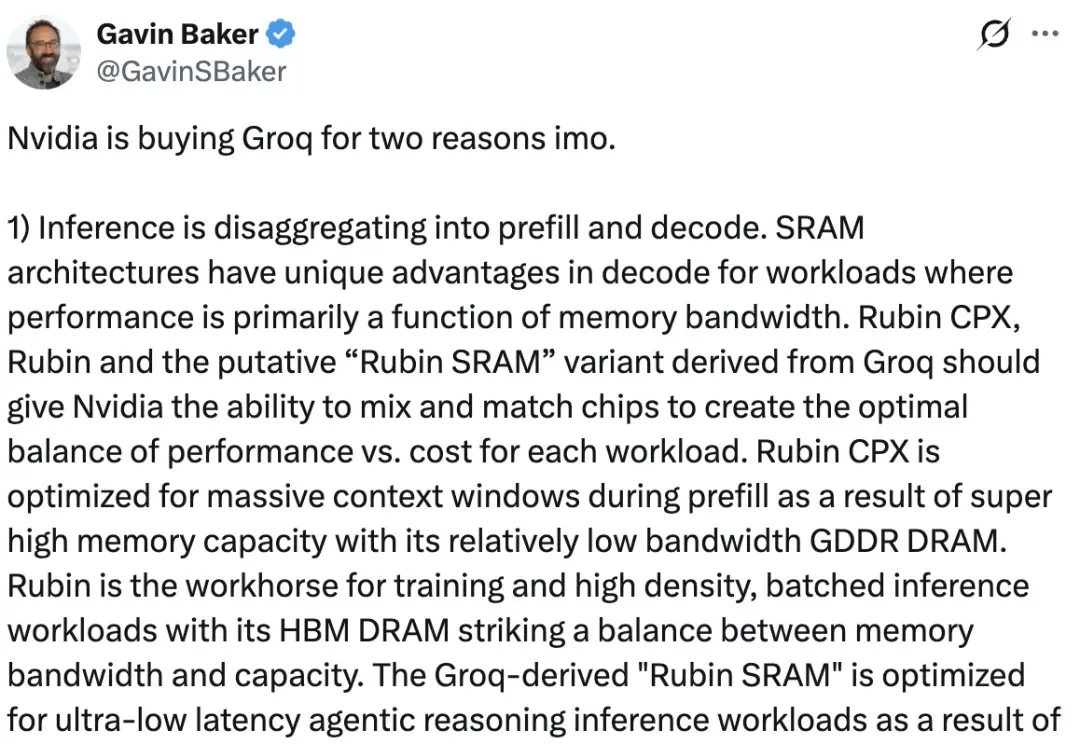

更多英伟达收购「TPU之父」创业公司Groq的细节曝光了—— 主打一个黄仁勋BOSS直聘。

老黄稳准狠,谷歌的TPU威胁刚至,就钞能力回应了。

平安夜老黄没有休息,一项200亿美元创纪录芯片收购消息,轰动硅谷。

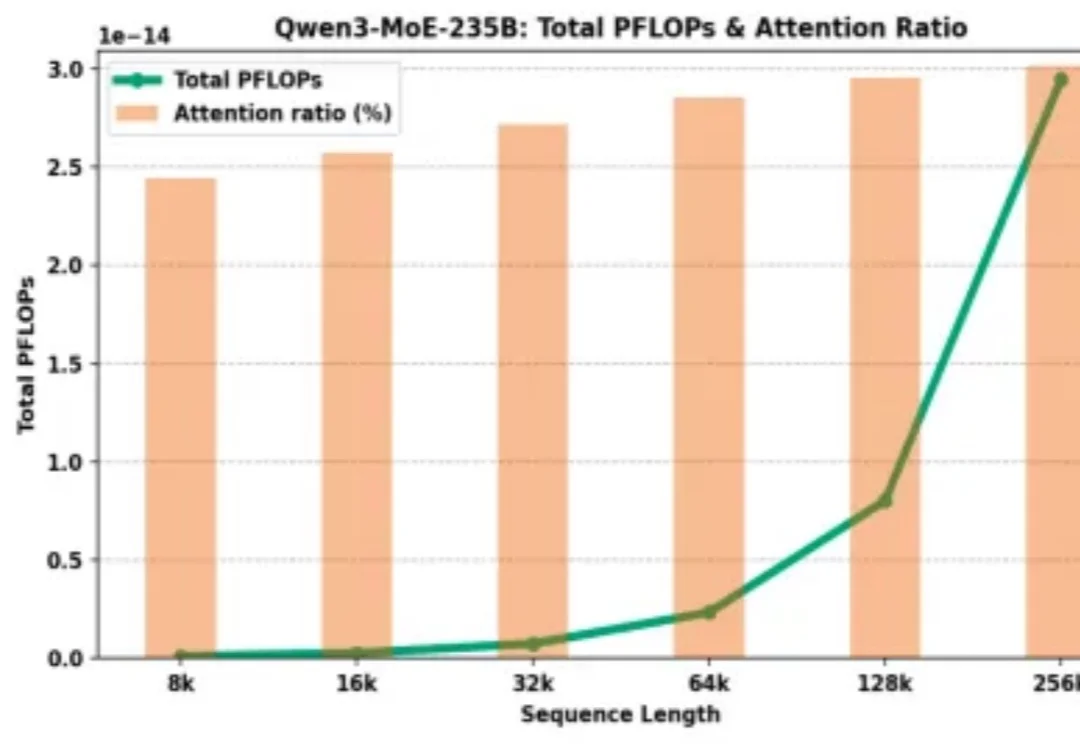

为什么大模型厂商给了 128K 的上下文窗口,却在计费上让长文本显著更贵?

刚刚,彼得·蒂尔一句话捅破天花板:AI芯片最终不会稀缺,将沦为白菜价。当AMD、ASIC、TPU、Trainium联手围剿,英伟达的暴利时代正在倒计时。

谷歌正在推进一项代号为「TorchTPU」的战略行动,核心是让全球最主流的 AI 框架 PyTorch 在自家 TPU 芯片上跑得更顺畅。这项行动不仅是技术补课,更是一场商业围剿。作为 PyTorch 的掌控者,Meta 也深度参与其中,两家巨头试图联手松动英伟达的垄断地位。

昨天,苹果一篇新论文在 arXiv 上公开然后又匆匆撤稿。原因不明。论文中,苹果揭示了他们开发的一个基于 TPU 的可扩展 RL 框架 RLAX。是的,你没有看错,不是 GPU,也不是苹果自家的 M 系列芯片,而是谷歌的 TPU!还不止如此,这篇论文的研究中还用到了亚马逊的云和中国的 Qwen 模型。

面对谷歌TPU的攻势,英伟达开始紧张了。