刚刚,OpenClaw史上最猛更新!AI记忆可自由插拔,开发者等了半年

刚刚,OpenClaw史上最猛更新!AI记忆可自由插拔,开发者等了半年OpenClaw推出v2026.3.7-beta.1,史上最密集一次更新:89项提交、200+Bug修复,核心亮点是全新ContextEngine插件接口——上下文管理终于可以「自由插拔」,不动核心代码就能换策略。这次更新值得每一个做AI Agent的人认真看。

OpenClaw推出v2026.3.7-beta.1,史上最密集一次更新:89项提交、200+Bug修复,核心亮点是全新ContextEngine插件接口——上下文管理终于可以「自由插拔」,不动核心代码就能换策略。这次更新值得每一个做AI Agent的人认真看。

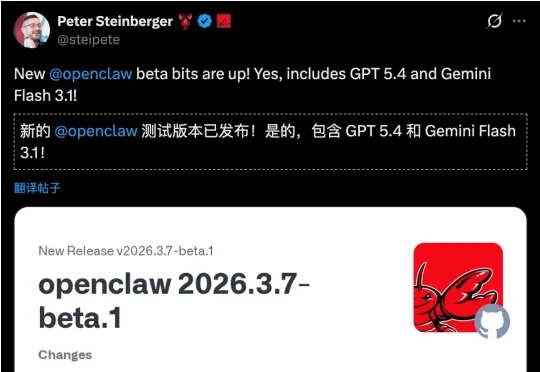

来自中国人民大学与阿里巴巴通义实验室的研究团队提出了 IterResearch,一种全新的迭代式深度研究范式。通过马尔可夫式的工作空间重构,IterResearch 让 Agent 在仅 40K 上下文长度下完成了 2048 次工具交互且性能不衰减,在 BrowseComp 上从 3.5% 一路攀升至 42.5%。

OpenAI 意外泄露 GPT-5.4!新版凭 200 万 Tokens 与「状态化 AI」实现跨会话持久记忆,并支持全分辨率视觉直读。AI 将从聊天工具向「全自动代理」进化,彻底重塑工作流并引爆底层硬件内存之战。

今天,Anthropic专为Claude上线了「导入记忆」(Import Memory)新功能,可一键丝滑搬家。只需一次简单的「复制粘贴」,就能将ChatGPT所有上下文,完整迁移至Claude。

在他们看来,真正的胜负手不在于单点技能拉满,而在于能否在同一颗芯片里,把“训练级吞吐”和“推理级低延迟”同时做好——尤其是在长上下文、Agent循环这些更复杂的真实工作流中。

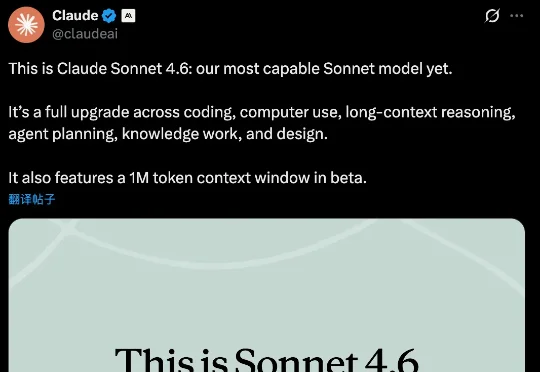

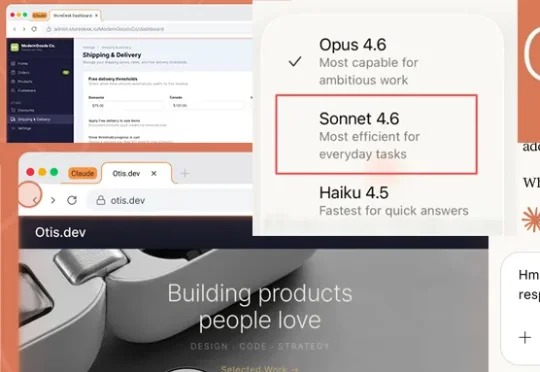

这次是 Anthropic,率先发布了他们称之为「我们目前能力最强的 Sonnet 模型」Claude Sonnet 4.6。Claude 称,新模型对编码、计算机使用、长上下文推理、智能体规划、知识工作和设计进行了全面升级。

据彭博社记者 Mark Gurman 爆料,苹果正在加速推进三款全新的 AI 可穿戴设备。这三款产品都将围绕 Siri 数字助手构建,通过摄像头获取视觉上下文来执行各种操作。

今日凌晨,Anthropic推出史上最强Sonnet模型——Claude Sonnet 4.6,新模型在编程、计算机使用、长上下文推理、Agent规划、知识工作和设计工作上全面进化。

确认了!DeepSeek昨晚官宣网页版、APP更新,支持100k token上下文。如今,全网都在蹲DeepSeek V4了。

当看到GLM-5正式发布后的能力,才惊觉前几天神秘模型Pony Alpha的热度还是有点保守了。