现在,业内关于AI模型收入的质疑声,已经越来越大。

动辄投入几万亿美元打造基础设施,跟部分国家的GDP不相上下,然而从AI模型中得到的回报,究竟能有几何?

在2023年9月,来自红杉资本的David Cahn发表了一篇名为《AI的2000亿美元问题》的文章,目的是探讨:「AI的收入都去哪了?」

根据报告,当时AI基础设施建设的预期收入,和AI生态系统的实际收入增长之间存在巨大差距。同时,这也反映了终端用户的价值。

对此,他解释道:「每年需要填补1250亿美元的空缺,以应对当前的资本支出水平。」

随着英伟达一度成为全球市值最高的公司,如今的「2000亿美元问题」是解决了,还是更加严重了?

结果出乎意料:AI的2000亿美元问题,现在已经变成了6000亿美元问题。

最近,David Cahn再次发表博文,对全世界提出警告:人工智能泡沫,如今正在接近临界点!

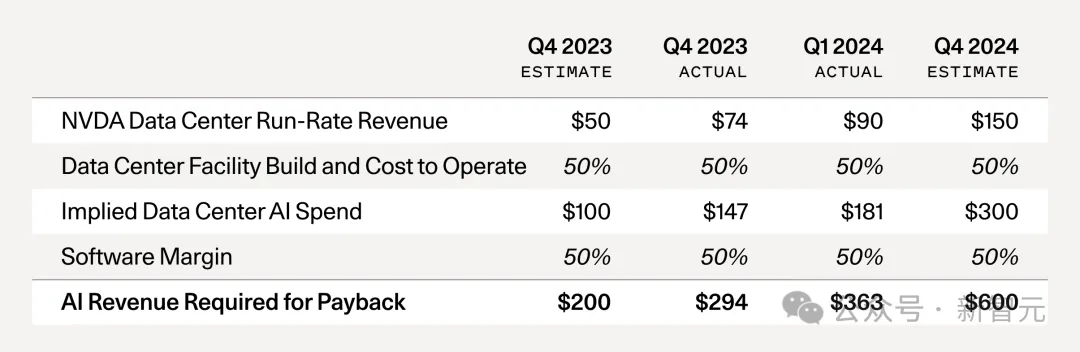

他列出了下面这张表格,并且详细解释了6000亿美元是怎么算出来的。

计算这个指标其实很简单。你只需将英伟达的年化收入预测乘以2倍,以反映AI数据中心的总成本(GPU占总成本的一半,另一半包括能源、建筑、备用发电机等)。然后再乘以2倍,以反映GPU终端用户的50%毛利率(例如,从Azure、AWS或GCP购买AI计算资源的初创公司或企业,他们也需要盈利)。

那么,自2023年9月以来发生了什么变化呢?David Cahn进行了以下总结。

1. 供应短缺已经缓解

2023年末是GPU供应最紧张的时候。当时,初创公司纷纷联系风险投资公司,甚至任何愿意帮助他们的人,只为获得千金难求的GPU。

如今,这种焦虑几乎完全消失了。如今的现状是,获取GPU变得很容易,交货时间也非常合理。

2. GPU库存正在增加

英伟达在第四季度报告中指出,其数据中心收入中约有一半,都来自大型云供应商。仅微软一家公司,可能就占了英伟达第四季度收入的约22%。

如今,超大规模的资本支出正达到历史新高。

这些投资也成为了大科技公司2024年第一季度财报的主要亮点,CEO们明确表示:「无论你们喜不喜欢,我们都会投资GPU。」

在业内,囤积硬件已经不是什么新鲜事了,一旦库存增加到足以减少需求,就会引发市场调整。

3. OpenAI仍然占据AI收入的最大份额

《The Information》最近报道,OpenAI的收入已增至34亿美元,在2023年末,他们的收入还是16亿美元。

虽然也有一些初创公司达到了不到1亿美元的收入规模,但显然,跟OpenAI相比,它们还在努力追车尾。

除了ChatGPT,今天消费者真正使用的AI产品有多少呢?

如果需要付费,每月15.49美元的Netfix,或者每月11.99美元的Spotify,岂不更香?

从长远来看,AI公司提供的价值需要足够显著,才能让消费者有持续的掏钱意愿。

4. 1250亿美元的空缺现在变成了5000亿美元的空缺

在上次分析中,David曾经做过这样一种乐观的的假设:每年,谷歌、微软、苹果和Meta能从新产生的AI相关收入中获利100亿美元。

他还假设,甲骨文、字节跳动、阿里、腾讯、X和特斯拉每家能产生50亿美元的全新AI收入。

即使这些假设仍然成立,并且再增加几家公司到名单中,那么1250亿美元的空缺,现在将变成5000亿美元的空缺。

5. B100即将到来

今年早些时候,英伟达官宣了B100芯片,它的性能提高了2.5倍,而成本却仅仅增加了25%。

David预计,这将最终导致对英伟达芯片的需求激增。

因为B100在成本与性能上较H100有显著提升,可能会导致今年晚些时候的又一次供应短缺,到时候大家都会争相抢购B100。

有人反驳上一篇文章时说道:「GPU资本支出就像修铁路,火车最终会来,目的地也会出现——比如新的农产品出口、游乐园、购物中心等等。」

对此,David表示赞同,但也提出了他们忽略的一些问题。

1. 缺乏定价权

在物理基础设施建设中,所建的设施本身是有一定的内在价值的。

如果你拥有从旧金山到洛杉矶的铁轨,你可能会有某种垄断定价权,因为在A地和B地之间,只能铺设有限的铁轨。

而在GPU数据中心的情况下,定价权则要少得多。

GPU计算,如今越来越像是一种按小时计费的商品。

不同于成为寡头垄断的CPU云,后来者正在持续不断地涌入市场,建设专用的AI云。

在没有垄断或寡头垄断的情况下,高固定成本+低边际成本的业务,价格竞争下降到边际成本几乎会成定局(比如航空公司)。

2. 投资焚烧率

即使在铁路建设中,投机性投资狂潮也往往会导致极高的资本焚烧率。

在新技术出现时,也是如此。

在关于技术投资的最佳教科书之一《推动市场的引擎》中,得出的主要结论是:在投机性的技术浪潮中,很多人损失了大量资金。(比如铁路)

想要找出赢家很难,但要找出输家,则容易得多。(在铁路的情况下是运河)。

3. 折旧

从技术历史中我们知道,半导体的发展会越来越好。

英伟达还将继续生产更强的下一代芯片,如B100。这将导致上一代芯片更快的折旧。

因为市场低估了B100和下一代芯片改进的速度,它高估了今天购买的H100在3-4年内保价的程度。

不过,这种情况在物理基础设施中是不存在的,因为物理基础设施不会遵循任何摩尔定律曲线,成本与性能也不会持续改进。

4. 赢家与输家

现在,我们需要仔细看看谁是赢家,谁输家——在过度的基础设施建设期间,总是会有赢家的。

David认为,AI可能是下一个变革性的技术浪潮,而GPU计算价格的下降,实际上对长期创新和初创公司是有利的。

如果他的预测成真,主要受损的就是投资者了。

而创始人和公司建设者将继续在AI领域创新,因为他们将受益于更低的成本,和在这一实验期间积累的经验教训。

因此,他们更有可能成功。

显而易见,AI将带来巨大的经济价值。那些专注于为终端用户提供价值的公司,终将获得丰厚的回报。

如今,我们正处在一个有潜力重新定义一代人的技术浪潮中。

像英伟达这样的公司,在这一变革中功不可没,并且很可能在未来很长一段时间内,都会继续在生态系统中扮演关键角色。

投机狂潮是技术发展的一部分,因此不必害怕。

在这个时刻保持冷静的人,有机会建起极其重要的公司。

但是,我们需要警惕那种从硅谷蔓延到全美,甚至全球的幻想:我们都能快速致富,因为AGI明天就会到来,我们都需要囤积唯一有价值的资源——GPU。

实际上,前方的道路将会很长。

它会有起伏,但可以肯定的是,这条路是值得走的。

参考资料:

https://www.sequoiacap.com/article/ais-600b-question/

文章来自于微信公众号“新智元”,作者 “Aeneas, 好困”