NeurIPS 2024评审结果已经公布了!

收到邮件的小伙伴们,就像在开盲盒一样,纷纷在社交媒体上晒出了自己的成绩单。

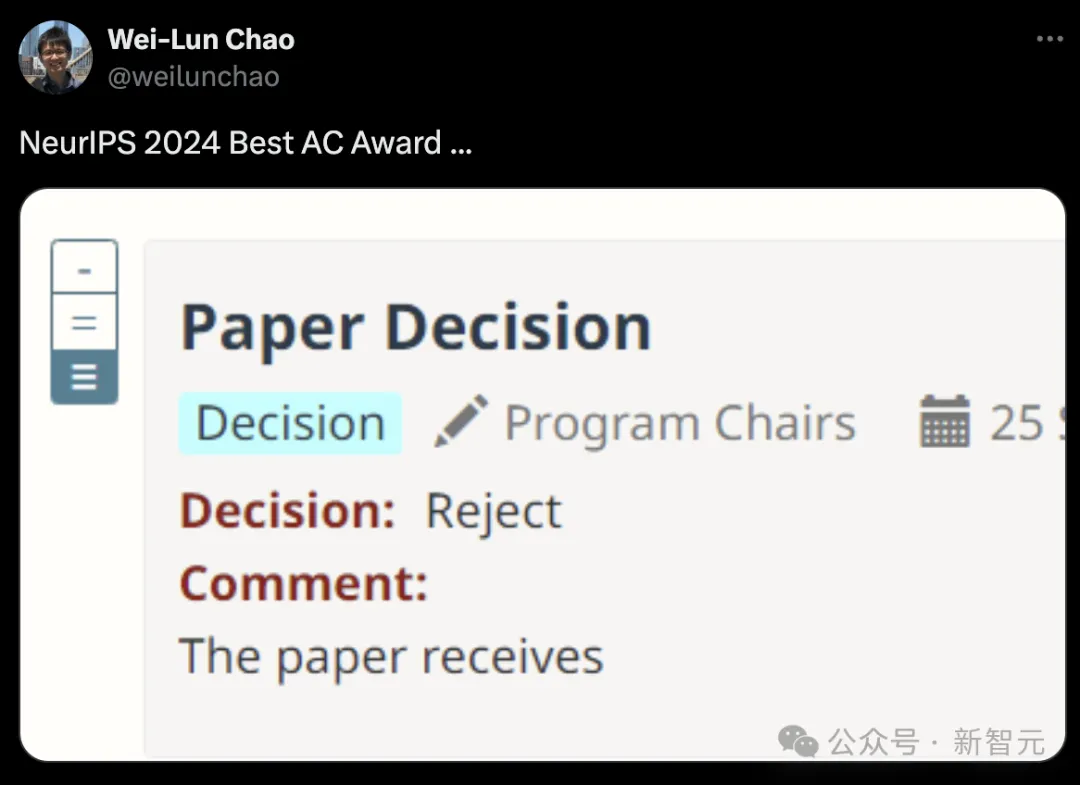

俄亥俄州立大学助理教授晒图,明明评审员给的评价是「论文接收」,却没想到最终决定是「拒收」。

应该给这位审稿人颁发一个NeurIPS 2024最佳AC奖

顺便提一句,今年是NeurIPS第38届年会,将于12月9日-15日在加拿大温哥华举办。

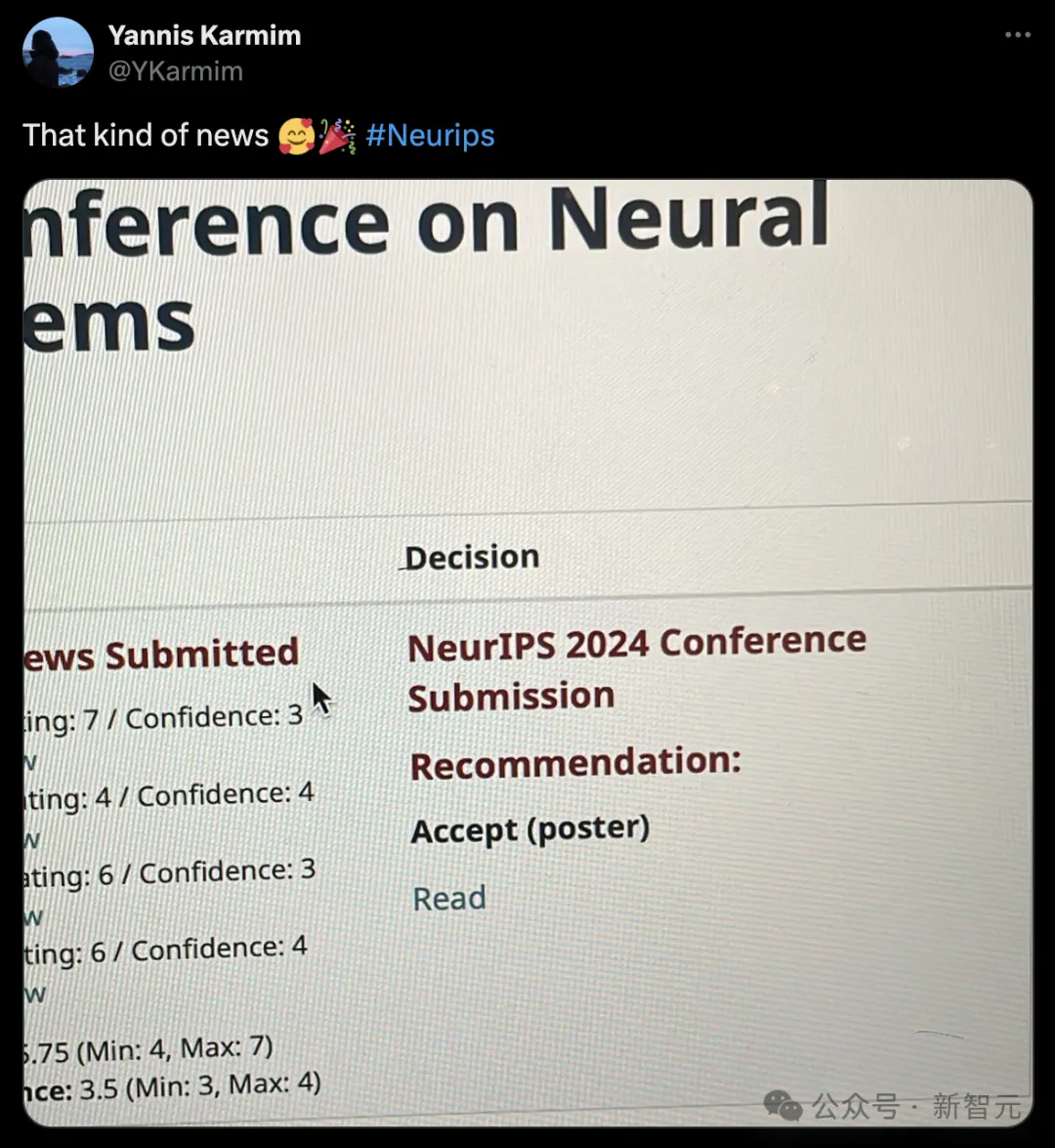

一些网友们早已晒出了自己的录用结果,好像一件大事。

来自洛桑联邦理工学院(EPFL)的博士Maksym Andriushchenko称,自己有3篇论文被NeurIPS 2024接收。

它们分别是:

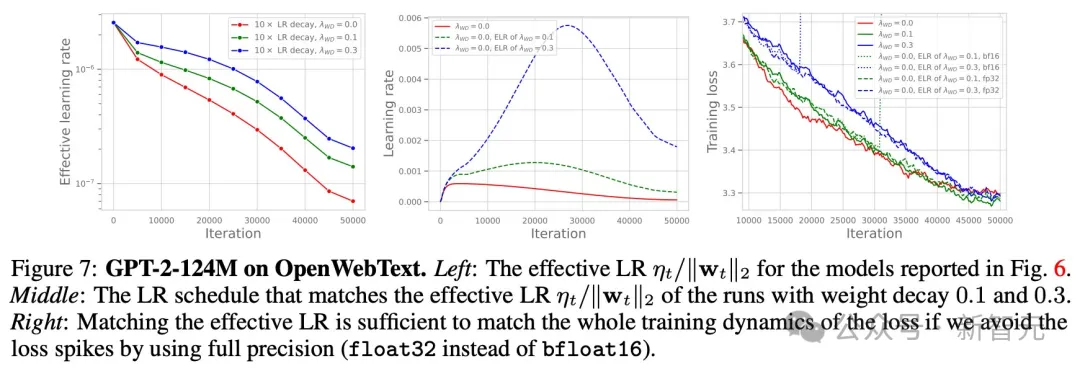

论文一:Why Do We Need Weight Decay in Modern Deep Learning?

论文地址:https://arxiv.org/pdf/2310.04415

权重衰减(weight decay),比如在AdamW中传统上被视为一种正则化的方法,但效果非常微妙,即使在过度参数化的情况下也是如此。

而对大模型而言,权重衰减则扮演者完全不同的角色。与最初一版arXiv论文相比,研究人员对其进行了很多更新。

Andriushchenko表示,自己非常喜欢这项新实验,并且匹配了AdamW有效学习率,得到了完全相同的损失曲线,而没有使用权重衰减。

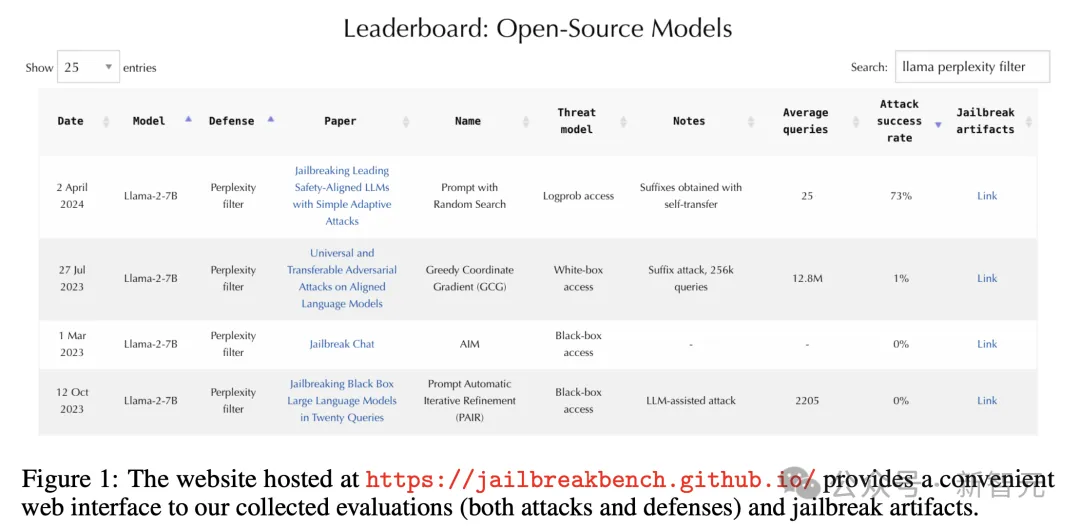

论文二:JailbreakBench(Datasets and Benchmarks Track)

论文地址:https://arxiv.org/pdf/2404.01318

JailbreakBench是全新评估大模型越狱能力的基准。上个月,该数据集在HuggingFace上,被下载了2500次。

而且,多家媒体还使用了这个越狱神器,Gemini 1.5技术报告中也将其用于模型稳健性的评估。

论文三:Improving Alignment and Robustness with Circuit Breakers

论文地址:https://arxiv.org/pdf/2406.04313

这篇论文发布之初,已经掀起了不少的讨论。

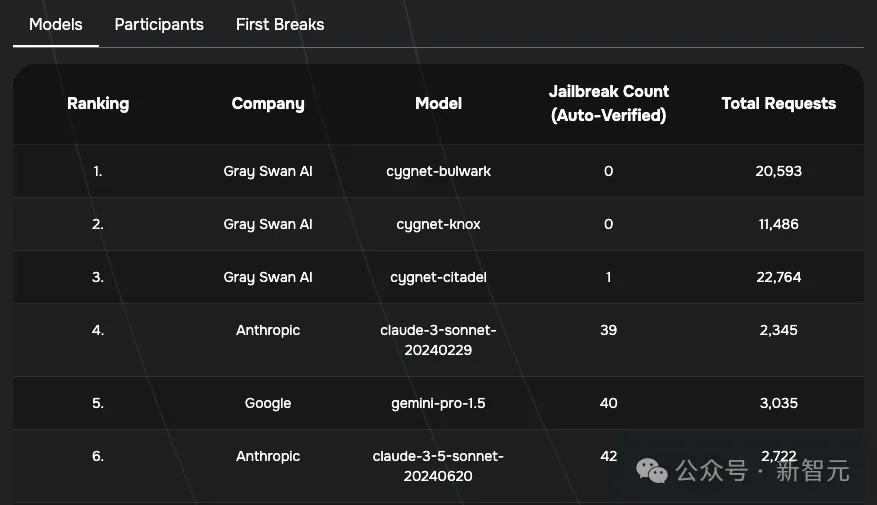

其中最重要的一点是,它有助于训练Cygnet模型,其在越狱竞技场上表现出惊人的性能,而这正是对防御是否有用的测试。

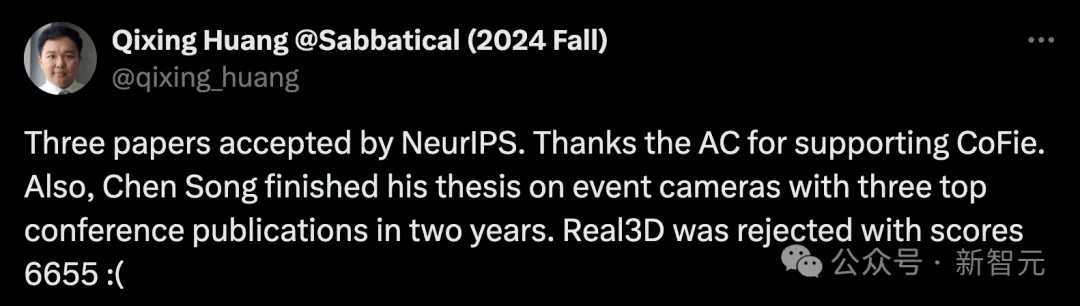

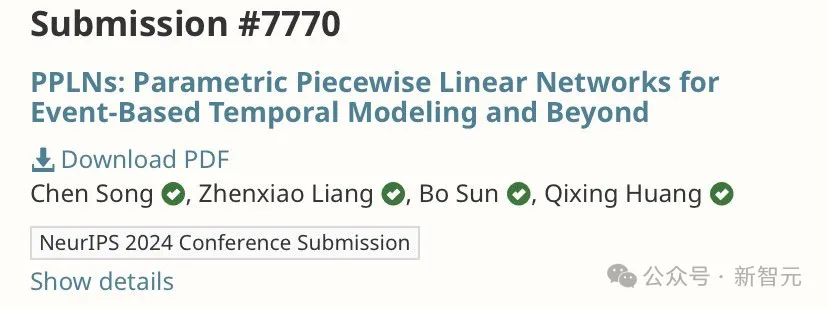

来自UT Austin的副教授Qixing Huang也有三篇论文被NeurIPS录用。

它们分别是:

局部几何感知神经曲面表示法CoFie。

以及另外两篇,一个是参数化分段线性网络PPLN,另一个是关于时空联合建模的运动生成。

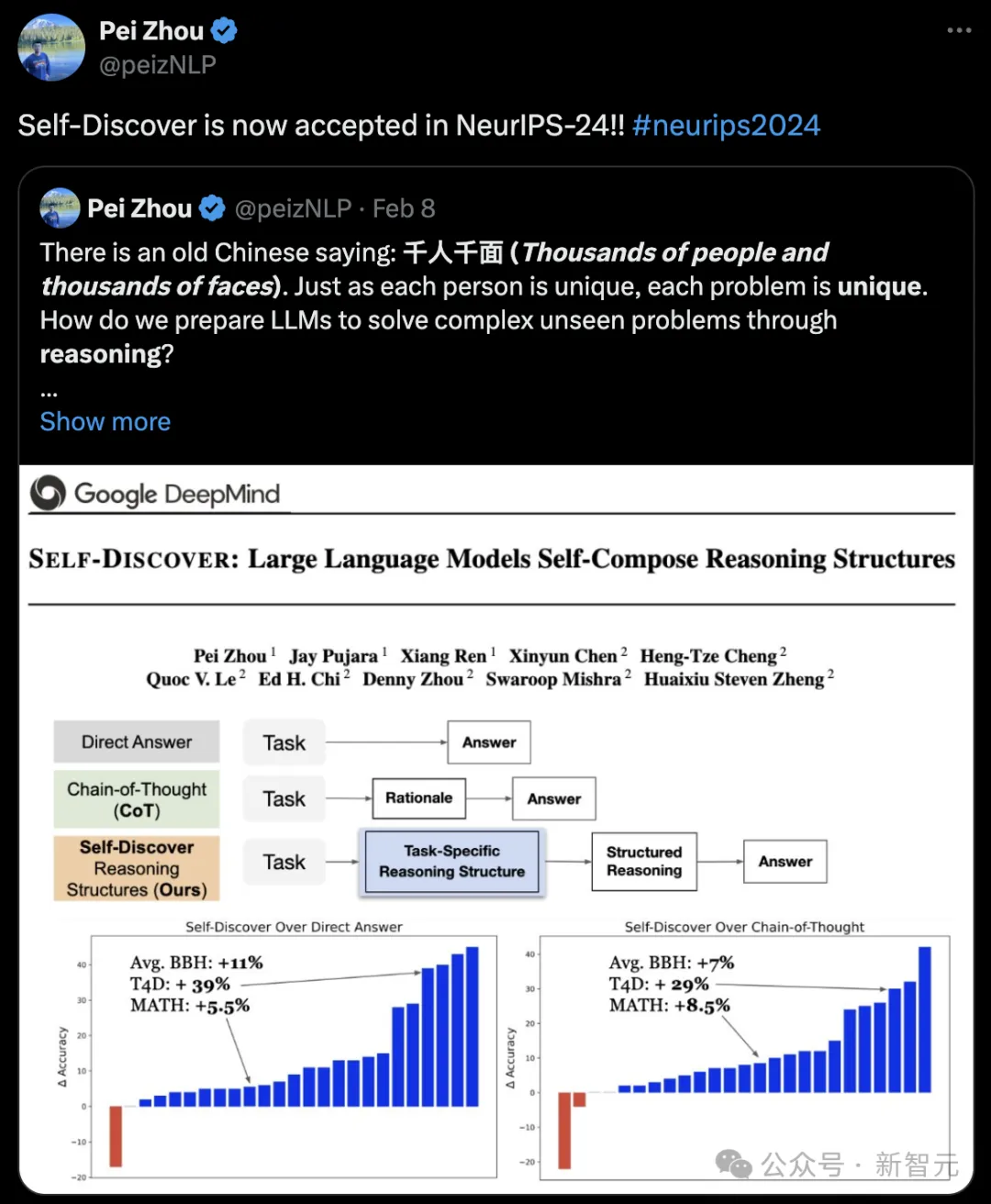

谷歌DeepMind团队Self-Discover算法被NeurIPS 2024录用。

中国有句古话:千人千面。正如每个人都是独一无二的,每个问题也是独一无二的。如何让LLM通过推理解决复杂的看不见的问题?

Self-Discover最新论文证明了,模型可以从一般问题解决技术的集合中,组成特定用于任务的推理策略。

最新算法在GPT-4和PaLm 2-L上的性能比CoT高32%,而推理计算量比Self-Consistency少10-40倍。

论文地址:https://arxiv.org/pdf/2402.03620

不论是哪个顶会,吐槽是必不可少的。

这不,网友们对NeurIPS 2024审稿结果,吵成一锅了。

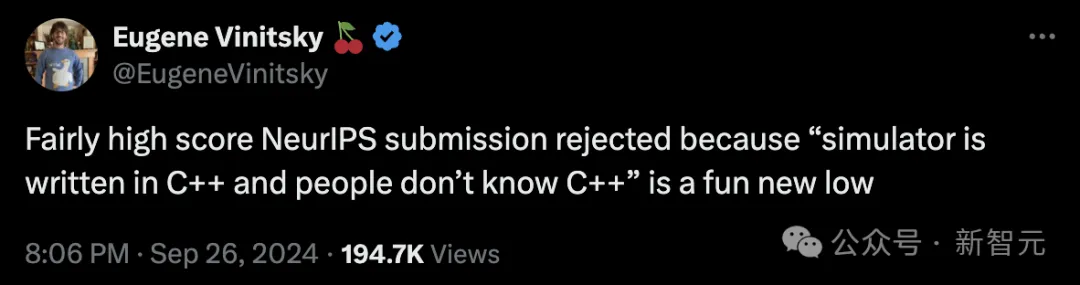

纽约大学工学院的助理教授称,一篇在NeurIPS提交中得分相当高的论文被拒绝。原因竟是:「模拟器是用C++编写的,而人们不懂C++」。

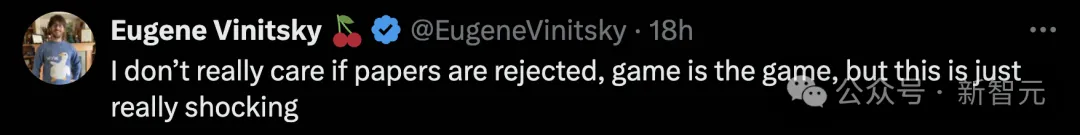

他表示,论文被拒的现象太正常了,但是对这个被拒理由,实在是令人震惊。

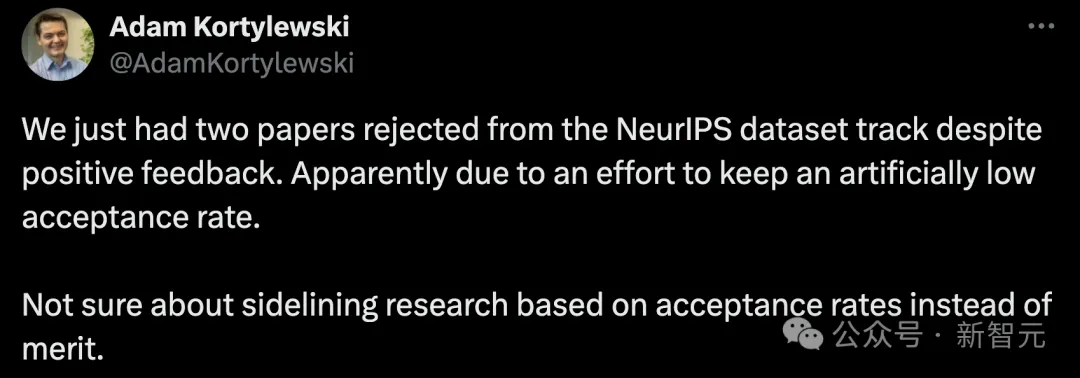

还有一位大佬表示,团队的两篇关于数据集追踪的NeurIPS论文被拒了,尽管评审结果有积极的反馈。

这显然是,组委会试图人为地标尺较低的录取率。

「根据录取率而不是成绩来排挤研究,这一点其实我不太确定」。

无独有偶,UMass Amherst的教员也表达出了这种担忧:

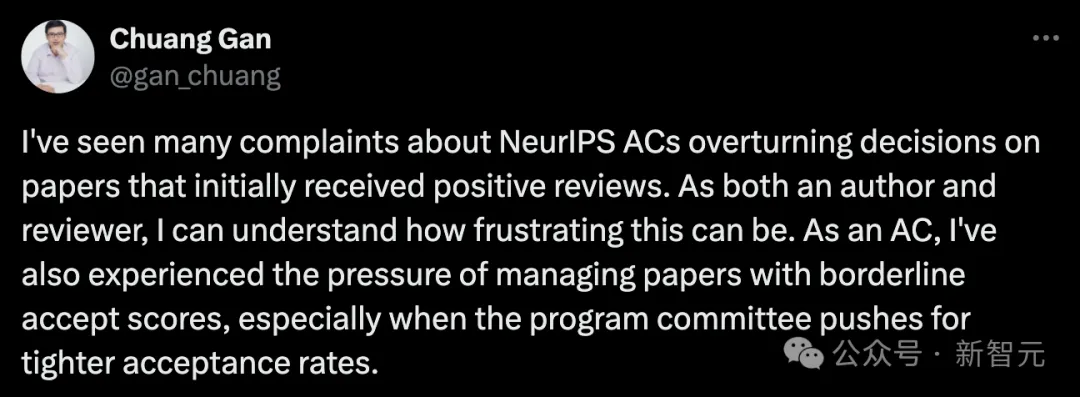

我看到很多人抱怨 NeurIPS的AC,推翻了最初收到积极评审论文的决定。

作为一名作者和评审员,我能理解这种做法有多令人沮丧。作为一名区域主席,我也经历过管理那些勉强达到录用分数的论文的压力,特别是当项目委员会要求更严格的录用率时。

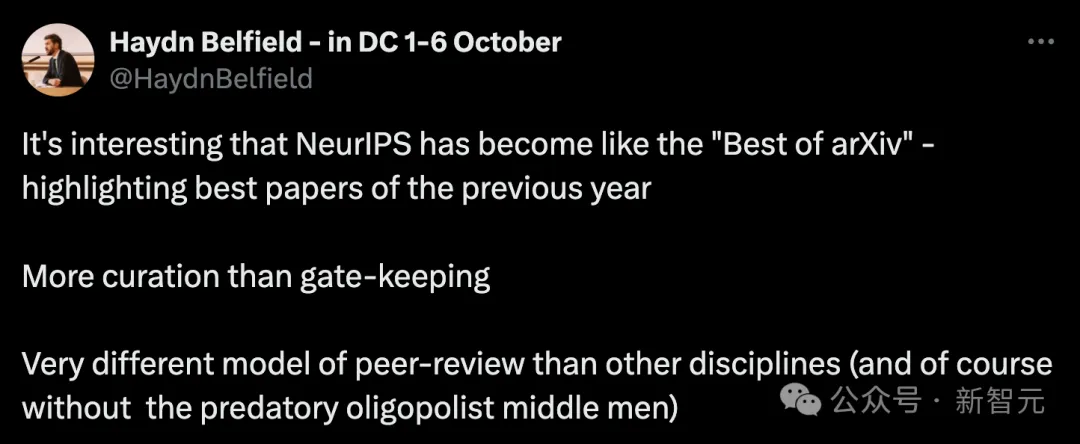

有趣的是,NeurIPS已经变得像「arXiv精选」——突出展示前一年的最佳论文。

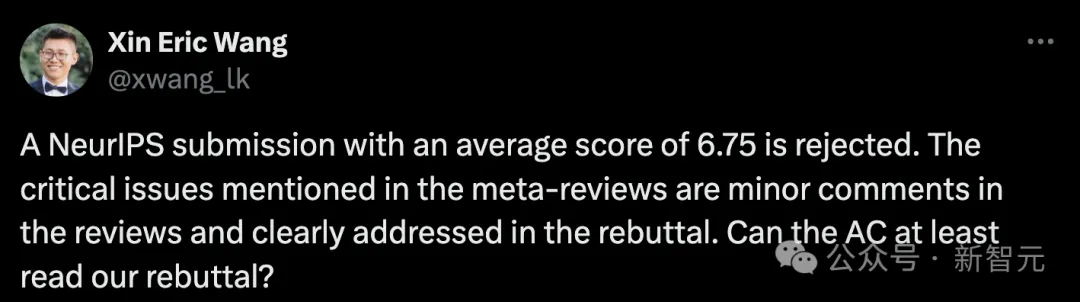

一位UCSC教授Xin Eric Wang表示,一篇平均得分为6.75的NeurIPS投稿被拒绝了。

他表示,这是自己收到第二荒谬的元评审,最荒谬的那次,是因为结果中没有加「%」就否决了论文。

无论论文质量如何,似乎总会有无数理由可以否决一篇论文。

元评审中提到的关键问题,在原始评审中只是小问题,而且他们团队已经在回复中明确解决。Xin Eric Wang怀疑AC是否真正阅读了他们的回复:

(1) AC提出了一个重大问题,这是基于一个得分为8分的评审者的小建议,引用了「大部分数据」,但实际数字小于10%(如回复中所述)。

(2) AC指出缺少统计数据,这些数据评审者从未提及,而且在论文正文中已经清楚地呈现。

而且AI火了之后,大模型也被用来论文评审。

这次,NeurIPS 2024也不例外。

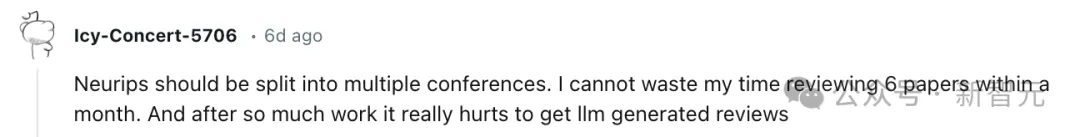

Reddit网友评论道,自己用一个月的时间审核6篇论文,当看到自己得到的是LLM的评价,真的很受伤。

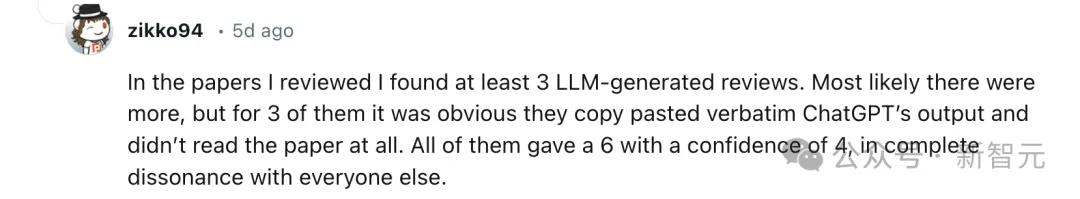

还有人指出,在自己审阅的论文中,至少发现了3篇由大模型生成的评审意见,很可能还有更多,其中3篇明显是直接复制粘贴了ChatGPT输出,完全没有阅读论文。

这些评审都给了6分,Confidence为4,与其他所有人的评价完全不一致。

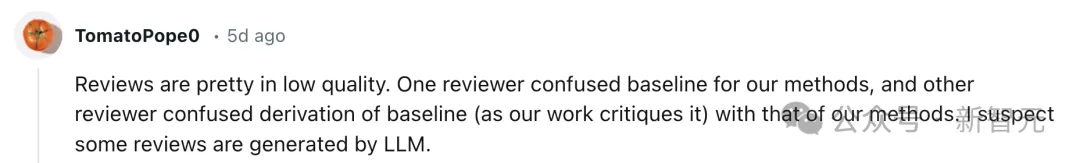

更有网友评价道,「论文评论的质量很低」。

一个评审者混淆了我们方法的基线,另一个评审者混淆了基线的派生(正如我们的工作所批评的那样)和我们方法的派生。我怀疑一些评论是由LLM产生的。

参考资料:

https://x.com/AlbertQJiang/status/1839048302794518806

https://x.com/PiotrRMilos/status/1839221714674229579

文章来自于微信公众号“新智元”